設立から1年でユニコーン入りしたことでも有名な東京発のAIスタートアップ Sakana AIが、LLMによる(大規模言語モデル)によるLLM開発の手法を発見しました。

ニュースの要約

AIの進歩はこれまで、研究者の試行錯誤と多くのリソースに依存していました。理想とする回答とモデルが出力する回答との乖離を是正するために、選好最適化アルゴリズム(Preference Optimization)が用いられていましたが、人間が人間の価値観や好みに合わせて調整をしていました。

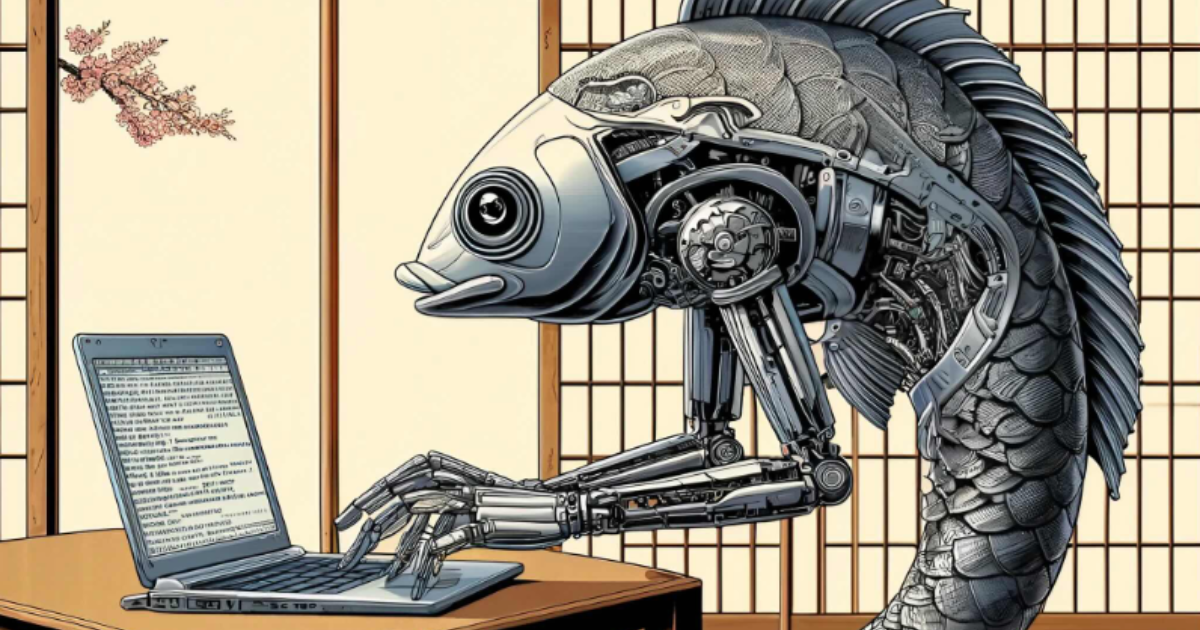

AIが仮説を生成し、コードを書く能力を持つようになったことをきっかけに、大規模言語モデル(LLM)を用いてLLM自身を開発する可能性に気づき、今年初めから開発に着手しました。

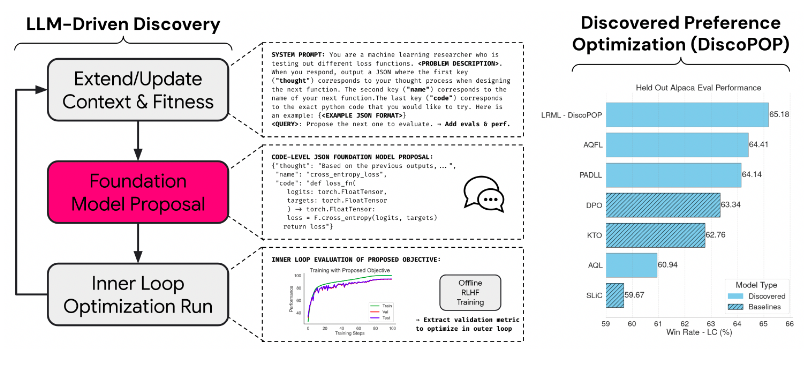

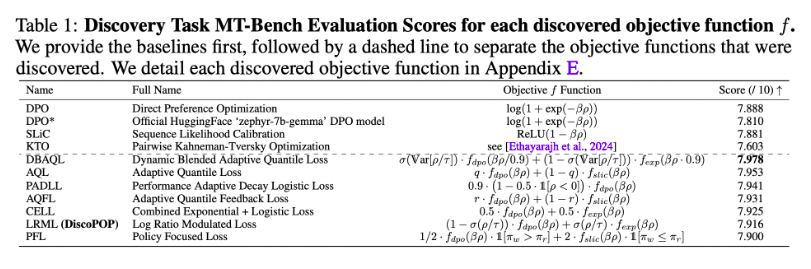

そして、最新の報告書「Discovering Preference Optimization Algorithms with and for Large Language Models」では、大きく3つのステップでAIを使った新しい選好最適化アルゴリズムを見つけ出したことを報告しています。LLMによってLLMを開発する取り組みについてSakana AIはLLM² (LLMの2乗)と呼んでいます。

100回の試行を行い、最も優れたパフォーマンスを示したものをリストアップしています。その中で、特に「LRML」というモデルが優れた結果を示したため、これをDiscovered Preference Optimization(DiscoPOP)と名付けています。

「Sakana AIのLLM改善手法」について一言

非常に専門的な内容であるため技術的な部分は難しくはありますが、LLMによるLLM開発が進むことでこれまで以上のスピードでAIの精度向上が進むことが想定されますし、一方でAI開発のセキュリティや倫理的側面の重要性も高まるでしょう。

また、昨今はノーコード・ローコードという概念でプログラミングの裾野も広がっていますが、いずれはLLMの裾野が広がり、GPTsとは言わず、パーソナライズされたLLMを個々人が開発するような日も来るのでしょう。