Google I/O 2025 では、Gemini 2.5 ファミリーの性能ジャンプから XR グラスまで、AI の最新潮流が一気に披露されました。本稿はその中でも、“モデル・インフラ・開発ツール” という技術基盤に的を絞り、相対的には開発者視点で押さえておくべき更新点をまとめています。Gemini 2.5 の各エディション、拡散型テキスト生成、10 倍速 TPU Ironwood などが実務にもたらすインパクトを俯瞰しつつ、導入前に考えておきたいポイントを整理しました。

Gemini 2.5 ファミリーのアップデート

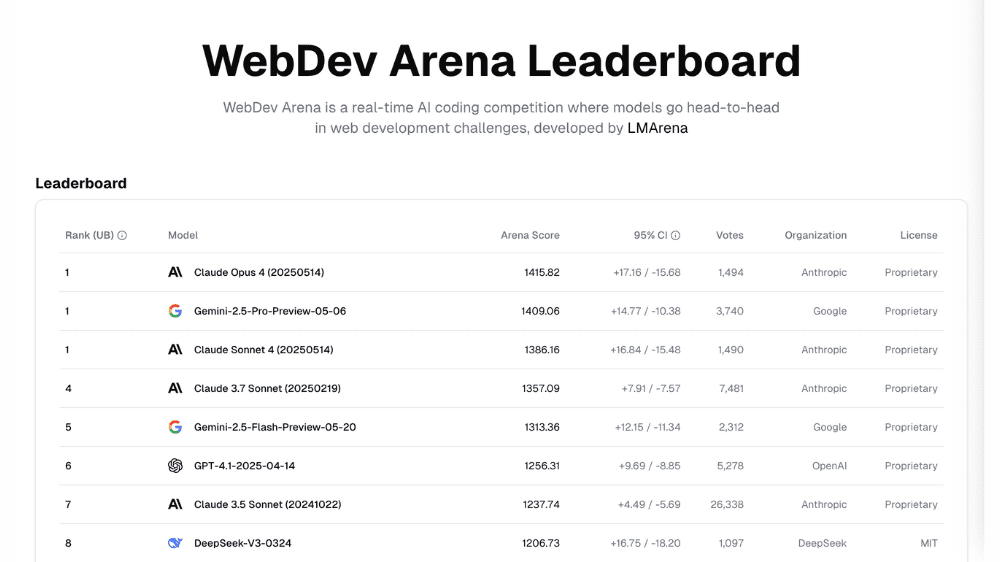

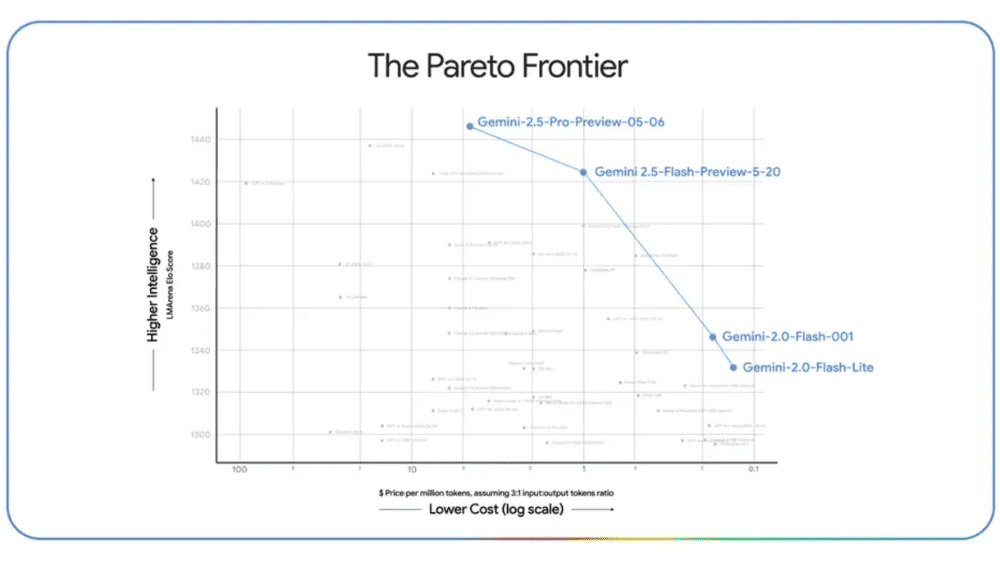

開発者向けにアップデートされた 2.5 Pro は、コーディングリーダーボード WebDev Arena で ELO 1420 を記録し首位に立つと同時に、LMArena でも全カテゴリを制覇しました。100 万トークンのコンテキストウィンドウにより、長大な仕様書や 4K 動画を丸ごと扱えるうえ、教育向けモデルファミリー LearnLM を統合したことで、学習科学の 5 原則すべてで既存トップモデルを上回る評価を獲得しています。今後もユーザー・開発者のフィードバックを取り込み、インタラクティブ Web アプリ構築をさらに加速させる方針です。

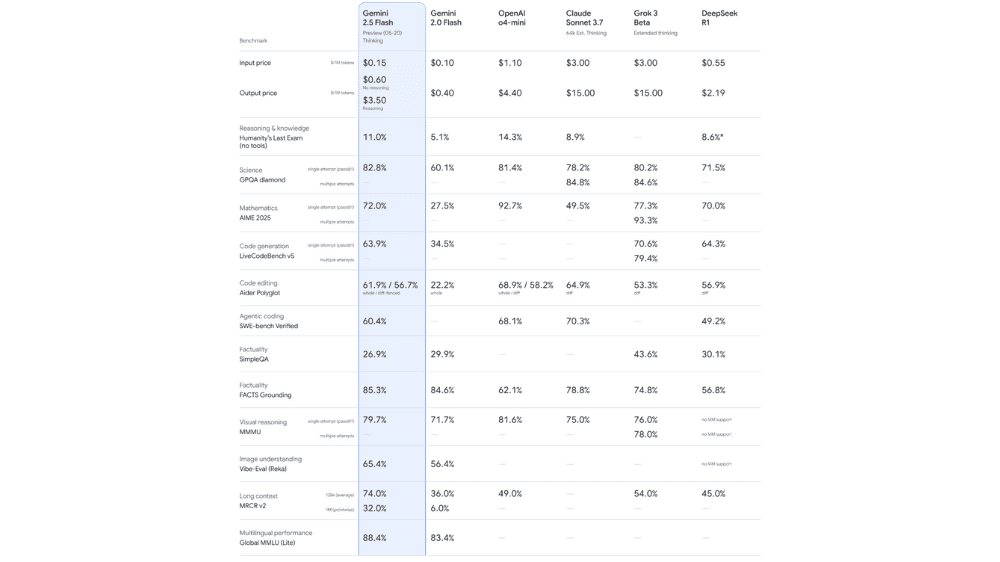

2.5 Flash は速度と低価格を徹底追求した主力モデルで、新バージョンでは推論・マルチモーダル・コード・長文コンテキストの各ベンチマークで一律にスコアを伸ばしました。内部効率化によりトークン使用量を 20〜30% 削減し、同等コストでさらに多くのリクエストをさばける設計です。Google AI Studio(開発者)・Vertex AI(企業)・Gemini アプリ(一般)の各プロダクトでプレビュー提供中で、6 月上旬には本番環境向けに一般提供(GA)が開始される見込みです。

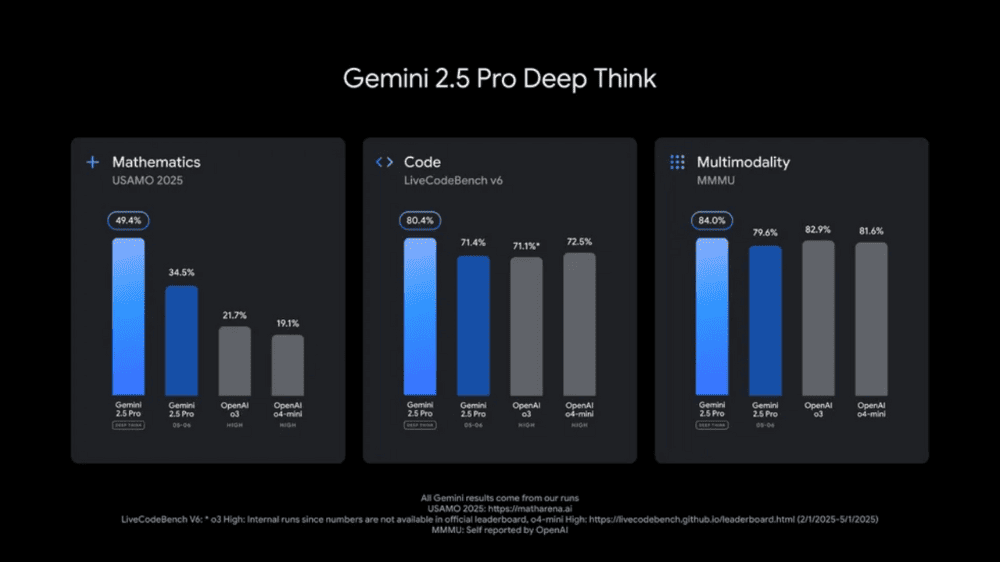

Deep Think は、応答前に複数の仮説を同時展開する新しい推論モードで、2025 USAMO など最高難度の数学ベンチで高スコアを収め、競技コーディング LiveCodeBench でもトップを獲得しました。マルチモーダル推論ベンチ MMMU では 84.0% を記録し、画像・動画入り問題でも安定した推論精度を示しています。最先端ゆえに安全性評価に追加時間を投じており、まずは Gemini API 経由で Trusted Tester に提供し、フィードバックを踏まえて一般公開される予定です。

開発ツールの連携:AI Studio / Vertex AI / Jules

Google はモデルだけでなく “作る場所” も一気通貫で用意しました。ここでは三つの代表ツールを、専門用語を補いながら噛み砕いて紹介します。

AI Studio はブラウザだけで動くプロトタイピング環境で、言わば Figma の AI 版。テキスト・画像・音声をアップロードしてモデルに渡し、その場で応答を確かめながらプロンプトを調整できます。完成したら “API Key をコピー” というワンクリックで外部アプリへ接続。今回のアップデートで追加された「画像 → three.js & React コード自動生成」機能により、UI モックを用意する作業が数時間→数分に短縮されます。

AI Studioで作った試作品を本番運用するのが Vertex AI。クラウド側でスケールや監視を肩代わりする “ホスティングサービス” と考えると分かりやすいでしょう。新機能 Managed Prompt Flow は、データベース検索・外部 API 連携・Chain‑of‑Thought などを ドラッグ&ドロップ式のフローチャート でつなぐノーコード UI で、RAG(検索拡張生成)パイプラインを数クリックで構築できます。

Jules は CLI(コマンドラインツール)で動くエージェント。例えるなら「24 時間待機の開発インターン」。jules migrate node@20 と打つと、リポジトリ全体をスキャンし、必要な依存を更新し、GitHub に PR を自動生成します。複数ファイルの変更計画を立ててから実行するので、“金曜日の深夜にライブラリをアップグレードしたら動かない” という事故が激減。β テスターからは「20 万行のプロジェクトが 5 分で Node.js 18→20 に移行できた」と好評です。

これら三つを組み合わせると、AI Studio(試作)→ Vertex AI(本番)→ Jules(保守) という開発ライフサイクルが1社内で完結します。非エンジニアでも「ブラウザで動きを確かめ、チェックを入れるだけで社内システムに埋め込める」とイメージしておくと、プロジェクト提案の際に役立ちます。

インフラの発展(TPU Ironwoodの活用)

TPU(Tensor Processing Unit) は、機械学習しか計算しない“AI 専用エンジン”です。今回の Ironwood はその第 7 世代にあたり、チップ 1 枚で見ると GPU に近い構造ですが、Google は何千枚も並べて Pod と呼ばれる 1 ラック丸ごとのスーパーコンピュータとして動かします。最新の Ironwood Pod が持つ計算力は 42.5 EFLOPS(4 K 映画 1 万本を 1 秒で解析できる規模)で、従来機 v5e に対して性能・電力効率ともに約 10 倍に跳ね上がりました。

今回のアップグレードで目玉となるのは三つです。まず マルチモーダル最適化。Gemini 2.5 が扱うテキスト・画像・音声の混在データを想定し、行列演算だけでなく“スパース・アテンション”や“3D 畳み込み”といった特殊演算をハードウェア側で高速にさばけるようになりました。次に 帯域ボトルネックの解消。Pod 内でチップ同士がやり取りする帯域が 8 TB/s を超え、巨大モデルを小分けに載せても計算が滞らないため、Deep Think のような重い推論でも待ち時間が伸びにくくなります。最後に Cloud での即利用。年内には Google Cloud から時間単位で Ironwood Pod を借りられるようになり、スタートアップでも「1 時間だけ最新 TPU で大規模推論」が現実になります。

実際、Google 社内では Ironwood + Gemini 2.5 の組み合わせで 月間トークン処理量が 1 年間で 50 倍 に膨らみました。開発者にとっては、長大なコンテキストや Deep Think の“濃い思考”をコストを抑えつつ試せる土台が整ったことが最大の恩恵です。今後は Vertex AI の Auto‑Scaling Pod によって負荷に合わせて Pod を自動増減させる機能も予定されており、ピーク時のキャパシティ計画が一段とシンプルになります。

Gemini Diffusion

画像生成 AI でおなじみの “拡散モデル” を、テキスト生成に横展開した実験版が Gemini Diffusion です。拡散モデルは「まずキャンバスをノイズだらけの下書きとして描き、余分な点を少しずつ消しゴムで消していく」ように、荒い出力を何回も磨き上げて完成させる方式です。対照的に従来の LLM は、左から右へ単語を 1 語ずつ足していく“順列生成(オートレグレッシブ)”でした。

この仕組みをテキストにも適用するとどうなるか――結果として Flash 2.0 比でおよそ 5 倍の高速生成 を達成しながら、コーディングや要約といった実用タスクでも同等品質を維持しています。理由は「仮説を書いて→間違いを削る」工程が内包されているためで、例えば長い数式証明や複雑なコードフォーマットの途中段階でも、誤りを見つけるたびに“消しゴム”が働いて軌道修正できるからです。

開発者にとっては ライブデバッグ向きの補完モデル として価値が高く、Gemini 2.5 Pro/Flash と組み合わせれば「高速ドラフト→拡散でブラッシュアップ→Pro で最終チェック」というパイプラインが組めます。研究プレビュー段階ですが、IDE 統合が進めば “Chat→修正→即テスト” のループがさらに短縮される見込みです。

Thought Summary / Thought Budget

LLM 運用の課題は「何にどれだけ計算を使ったか見えない」点でした。Gemini 2.5 は Thought Summary によってツール呼び出しやサブゴールを階層化表示します。これにより、プロンプトインジェクション対策(悪意ある入力文でモデル挙動を乗っ取る攻撃への防壁)としてのガードレール・ログを兼ね、SOC監査(米国公認会計士協会が定める System and Organization Controls 監査)の証跡にも利用可能です。

一方の 思考予算 は max_thought_tokens のような形で設定し、モデルが許可されたトークン量に達したら回答をまとめる仕組み。高負荷ジョブの “時間無制限暴走” を抑えつつ、Flash と Pro を切り替えて階段的に品質を上げる運用も組みやすくなりました。

世界モデルの開発

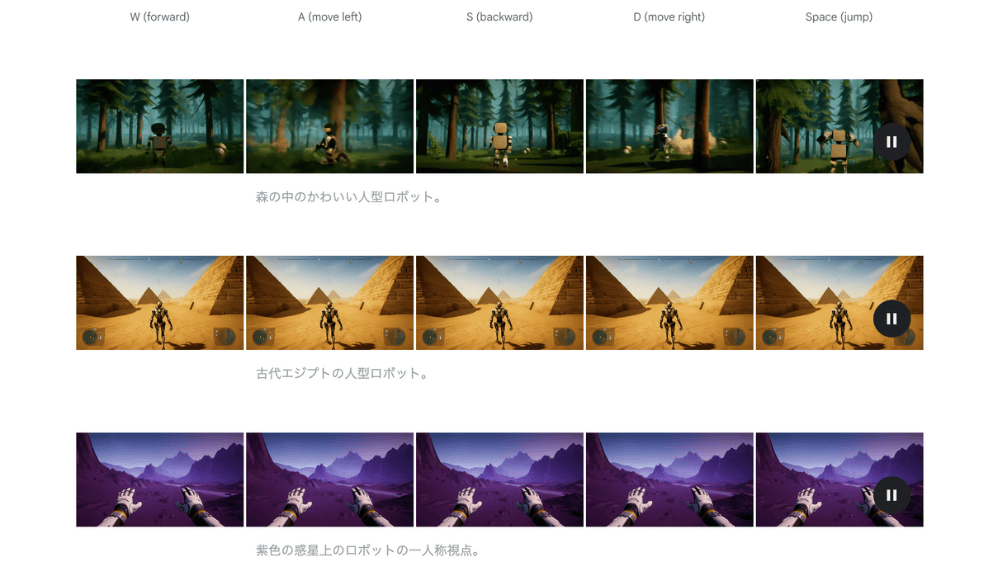

DeepMind が打ち出した 世界モデル 構想は、Gemini を物理環境や因果関係まで内包する総合モデルへ進化させるロードマップです。Genie 2 が 1 枚の画像から 3D シミュレーション環境を生成し、Gemini Robotics はロボットアームのグラス把持を数ショット学習で実現。開発者視点では、シミュレーション→リアル の転移学習 API が一般公開されたときに、製造・物流で「物理を知らない AI」が Zero‑Shot(事前の個別学習なしで初見タスクを実行) にロボットを動かす時代が到来します。

「Google I/O 2025 」について一言①(続く)

Deep Thinkによる推論の深化は確かに画期的ですが、この技術がどのタイプの業務に真価を発揮するかは慎重に見極める必要があります。現状では、難易度の高い問題——つまり前例のない、この世の誰も答えを知らないようなアカデミックな領域——での貢献が最も期待できるでしょう。USAMO(全米数学オリンピック)での高スコア獲得は、まさにこの方向性を裏付けています。しかし、これは同時にビジネス上の課題も浮き彫りにします。汎用性に乏しく、即座に収益につながらない研究開発的な性質が強いため、企業にとっては投資対効果の判断が難しくなります。今後の成長の鍵は、これまで明確に存在していたR&Dと事業の境界線をいかに溶解させるかにかかっています。

開発ツール領域では、OpenAIやClaudeといったLLMプロバイダー側と、CursorやDivineなどのアプリケーション側から、自律性のレベルが異なる多様なサービスが市場に投入されています。Geminiも今回、AI Studio、Vertex AI、Julesという包括的なツールチェーンを提供し、全方位戦略を展開しました。興味深いのは、どのツールもUIの収束点は似通っている点です。最終的にはモデルの根本的な差異が決定的な競争優位を生むのかもしれません。特にコーディングエージェント領域は、エージェント化の進歩が他分野を大きく上回っており、ベストプラクティスの議論が早晩収束する可能性が高いと考えられます。