Googleは、大規模言語モデル(LLM)の応答における事実性と信頼性を向上させるため、新たなオープンモデル「DataGemma」を発表しました。LLMによるハルシネーション(事実と異なる回答を生成すること)を低減するため、Googleは膨大な統計データを持つData Commonsを活用し、データ取得と応答生成の手法であるRIG(Retrieval Interleaved Generation)とRAG(Retrieval Augmented Generation)を採用しています。Hugging Faceからダウンロードが可能です。

DataGemmaの活用データ

大規模言語モデル(LLM)は情報処理に革命をもたらしましたが、検証可能な事実に基づいて回答を生成することは課題として残されています。現実世界の知識は多くのソースに分散し、データ形式が異なるため、アクセスおよび統合が困難であり、(正確なデータが取得できることで)ハルシネーションが起きています。

Data Commonsは、Googleが公開するデータベースで、国連や世界保健機関、各国の政府機関など信頼できる組織から提供された2500億を超えるグローバルなデータを含んでいます。経済、気候変動、健康、人口統計など、多岐にわたるトピックを網羅しています。この公開リポジトリは、AIの事実基盤を強化する豊富なデータソースとして機能し、LLMの応答の信頼性を向上させる鍵となります。

RIGとRAGの活用

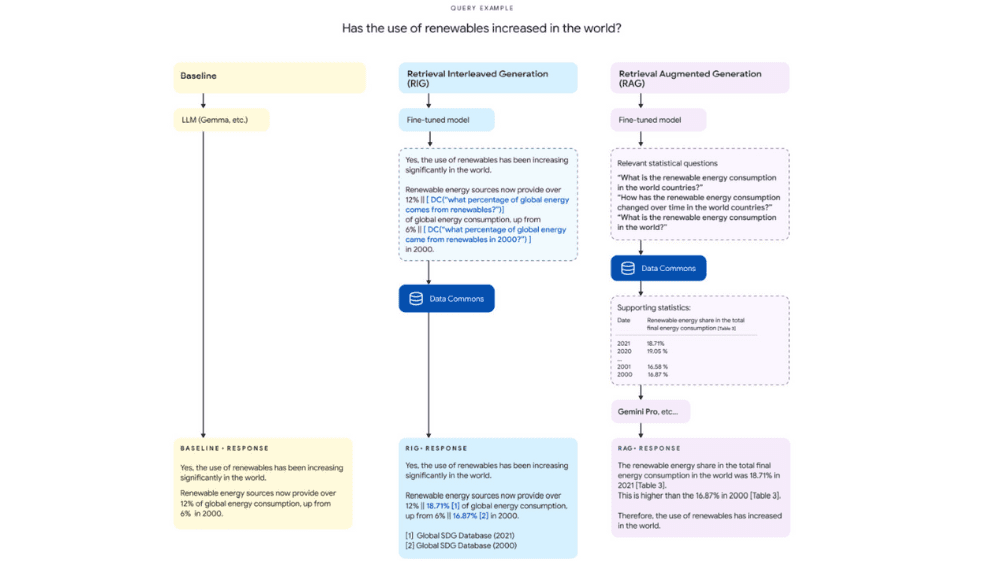

DataGemmaは、LLMをData Commonsのデータと組み合わせ、応答の正確性を高めるために、「Retrieval Interleaved Generation(RIG)」と「Retrieval Augmented Generation(RAG)」という2つの手法を採用しています。

まず、RIG(Retrieval Interleaved Generation)では、ユーザーからの質問に対してLLMが初期の回答を生成しますが、その後、Data Commonsから正確なデータを取得し、初期の回答内の情報を修正・補完します。これにより、ユーザーの質問を変更せずに、信頼性の高い情報を提供します。ただし、モデル自体がData Commonsから取得した情報を保持することはできないため、2次的な質問に同じ参照データを活用することはできません。

一方、RAG(Retrieval Augmented Generation)では、LLMがユーザーの質問を分析し、Data Commonsから関連する情報を取得します。そして、取得したデータを元の質問に追加し、LLMが詳細かつ事実に基づいた回答を生成します。これにより、モデルは最新のデータを活用して応答を生成でき、情報の正確性が向上します。しかし、ユーザーの質問が内部的に変更されるため(Data Commonsからの追加情報により)、ユーザーの意図した問いかけと異なる可能性があります。

「DataGemma」について一言

ハルシネーションは、言語モデル全体に共通する課題ですが、今回のDataGemmaは軽量モデルに焦点を当て、データとモデルの両面からこの問題を改善しようとしています(GoogleではGeminiが有名ですが、処理速度の速い軽量モデルであるGemmaも同時に開発しています)。

学習データとして、一般的にはウェブサイトから抽出されたCommonCrawlやC4といったデータソースが有名ですが、今回はよりアカデミックであり、信頼性の高いData Commonsを活用しています。モデルに関しても、RIGやRAG自体は新しい技術ではありませんが、これらを組み合わせて活用することで、応答の正確性を高めています。少し紛らわしいですが、RIGが先に回答を生成した後にData Commonsで回答を比較するのに対し、RAGは先にData Commonsで情報を取得した後に回答を生成するという意味で、前後関係に違いがあります。

人間であっても的外れな回答はよくあることであり(特に口語の会話など)、ハルシネーション自体が語義矛盾とも言えます。しかし、DataGemmaがどこまで精度を向上させ、信頼性の高いAIの実現に貢献できるか、今後の展開に注目していきたいと思います。

出所:Grounding AI in reality with a little help from Data Commons