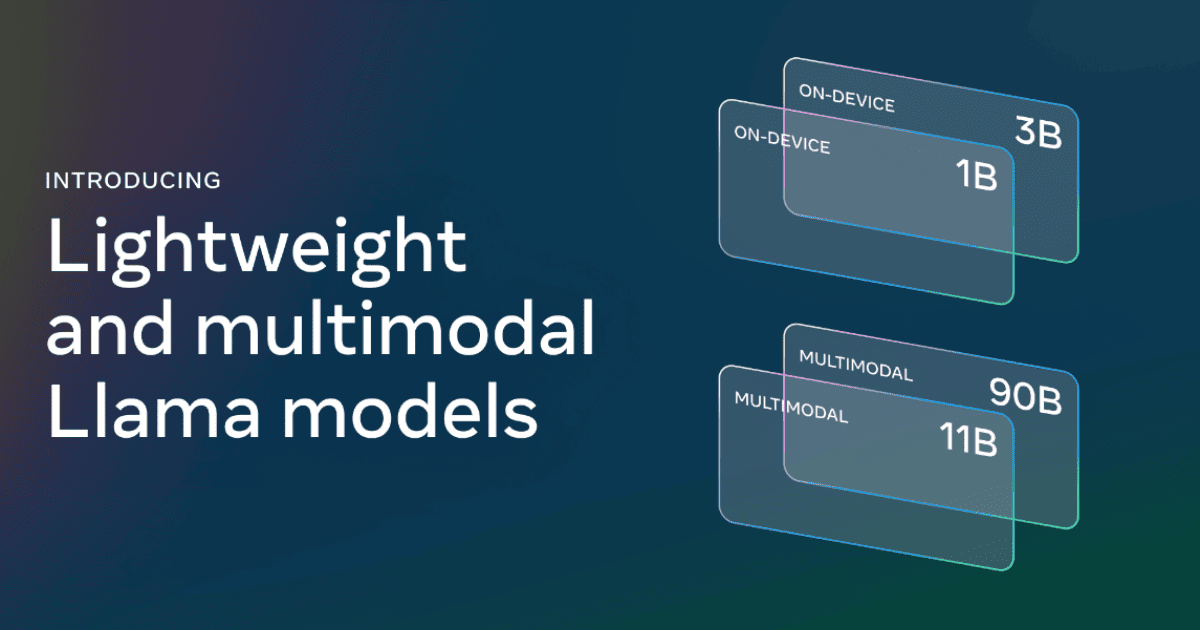

2024年9月25日、Metaはオープンでカスタマイズ可能な大規模言語モデル「Llama 3.2」を発表しました。エッジデバイス(外部ネットワークとの接続を介さないPCやモバイル内で完結する)やクラウド環境で利用できる軽量なテキストモデルと、画像理解に特化したビジョンモデルの2つを提供し、開発者が多様なユースケースに対応できるようにしています。

Llama 3.2の概要

MetaのLlama 3.2は、さまざまなユースケースに対応するオープンでカスタマイズ可能な大規模言語モデルの最新バージョンです。今回は、軽量なテキストモデルと強力なビジョンモデルをそれぞれ提供し、エッジデバイスやモバイル、クラウド環境において、より高度なAIソリューションを実現します。

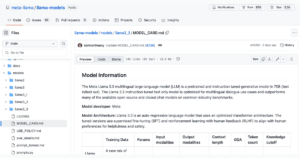

特に注目すべきは、開発者向けのLlama Stackディストリビューションの導入です(アプリケーションの作動環境)。これにより、オンプレミス(自社環境)、クラウド、さらにはデバイス上での操作が容易になり、検索拡張生成(RAG)やツール対応アプリケーションを迅速に展開できる環境が提供されます。このディストリビューションは、AWSやDatabricks、Dell Technologies、Infosysなどのパートナーと連携して開発されており、PyTorch ExecuTorchやOllamaといったプログラミング言語を介してデバイスや単一ノードでのディストリビューションが可能です。

Llama 3.2は、llama.comやHugging Faceでダウンロードできるほか、AMD、Google Cloud、IBMなど、幅広いパートナープラットフォームで利用可能です。

ビジョンモデル

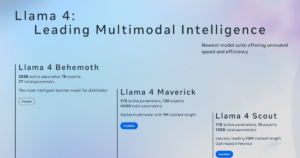

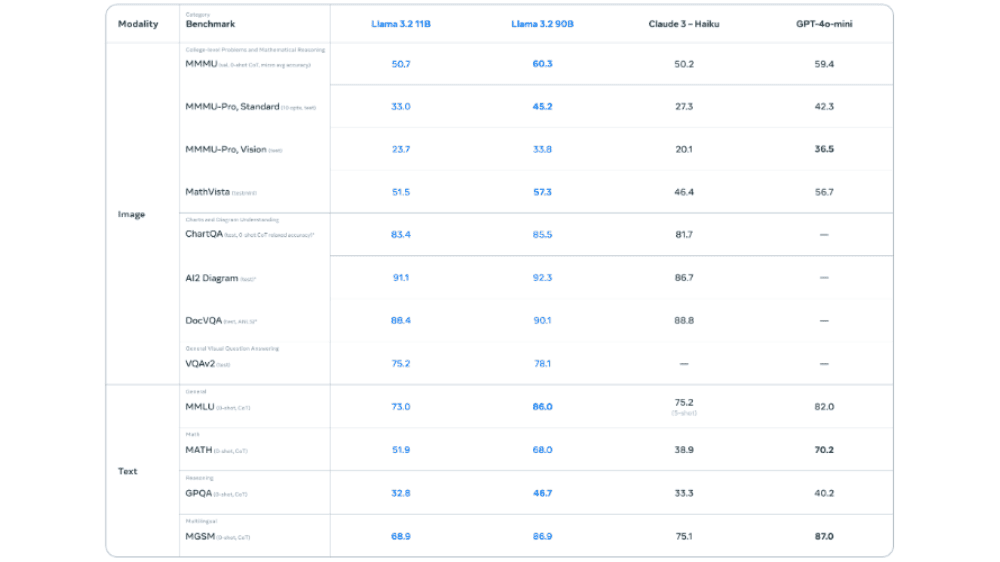

Llama 3.2の11Bおよび90Bビジョンモデルは、視覚タスクに特化した新しいアーキテクチャを採用しており、画像の理解と推論能力を大幅に向上させています。これらのモデルは、画像キャプション生成や画像内のオブジェクト認識といった視覚的タスクに対応しており、自然言語の説明に基づいて画像から詳細な情報を引き出すことが可能です。例えば、ビジョンモデルは複雑なグラフやチャートを解釈し、それに基づいて質問に答えることができます。

Llama 3.2のビジョンモデルは、主要な視覚理解タスクにおいて高いパフォーマンスを示しており、Claude 3 HaikuやGPT4o-miniなどのクローズドモデルに匹敵、もしくはそれを上回る結果を出しています。Metaの評価では、150以上のベンチマークデータセットを用いてモデルの性能を検証し、画像認識や視覚推論において優れた結果を達成しました。

テキストモデル

Llama 3.2の1Bおよび3Bテキストモデルは、エッジデバイスやモバイルデバイス向けに最適化されており、低リソース環境でも高性能を発揮することが特徴です。これらのモデルは、トークンのコンテキスト長を128Kまでサポートし、指示出しや要約といった多様なテキスト生成タスクに対応しています。特に、デバイス上で実行するアプリケーションにおいて、データをクラウドに送信することなく、プライバシー保護を維持したまま迅速に処理を行える点が強みです。多言語対応のテキスト生成やツール呼び出し機能に優れ、受信メッセージの要約やアクションアイテムの抽出、カレンダー招待の送信など、ビジネスやパーソナルアシスタントとしての用途に最適です。

Llama 3.2の軽量テキストモデルも評価において高いパフォーマンスを示しており、特に命令追跡や要約といったタスクでは、Gemma 2 2.6BモデルやPhi 3.5-miniモデルを上回る結果を記録しました。Metaは、これらの軽量モデルを150以上の言語に対応するベンチマークデータセットで評価し、幅広いテキスト生成タスクでの競争力を確認しました。

「Llama3.2」について一言

今回は、オープンソースの言語モデル開発に関する話題です。OpenAI、Googleの開発する言語モデルはクローズドモデルでありコードは公開されていない一方で、MetaのLlamaはオープンソースになればエンジニアとしての経験があれば、呼び出して個人レベルで開発・編集が可能です。

今回のニュースについては、ビジョンモデル、テキストモデルそれぞれのアップデートの素晴らしさもさることながら、少し表現が難しい「Llama Stackディストリビューション」が重要かと思っています。専門的ですが、ディストリビューションはPCのOSを含めた、PCが稼働するための統合的な環境を指します。「Llama Stackディストリビューション」はLlamaを言語モデルとしてだけでなく、メールの要約、カレンダーの呼び出しなどその他の機能と統合して機能させるための環境です。ざっくり言うと、Llamaを使ってできることが増えるので、より開発者に選ばれる可能性が高まるということになります。

出所:Llama 3.2: Revolutionizing edge AI and vision with open, customizable models