Model Context Protocol(MCP)とは、LLMのコンテキスト情報を、モデル内のコンテキストウィンドウに依存せず、外部で効率的に管理し、動的に提供・更新する技術です。MCPは、LLMを搭載したAIアプリケーションが外部データソースやツールとシームレスに連携できるように設計されたオープン標準プロトコルで、開発者が信頼性高くAIシステムに必要なコンテキストや機能を提供できるようにします。MCPは、従来のアプリケーションごとに個別に必要だったデータ連携を標準化し、開発効率の向上や外部リソースとの相互運用性を高めることができます。

Model Context Protocol(MCP)とは

Model Context Protocol(MCP)とは、LLM(大規模言語モデル)の文脈情報をモデル内のコンテキストウィンドウ(モデルが一度に処理できるトークン数のこと)に依存するのではなく、外部で効率的に管理し、動的にLLMに提供・更新する技術です。

MCPは、LLMを搭載したAIアシスタントやAIアプリケーションが外部データソースやツールとシームレスに連携するために設計されたオープン標準プロトコルです。このプロトコルは、従来アプリケーションごとに個別のカスタム実装が必要だったデータ連携を標準化し、開発者がAIシステムに必要なコンテキストや機能を信頼性高く提供できるようにします。

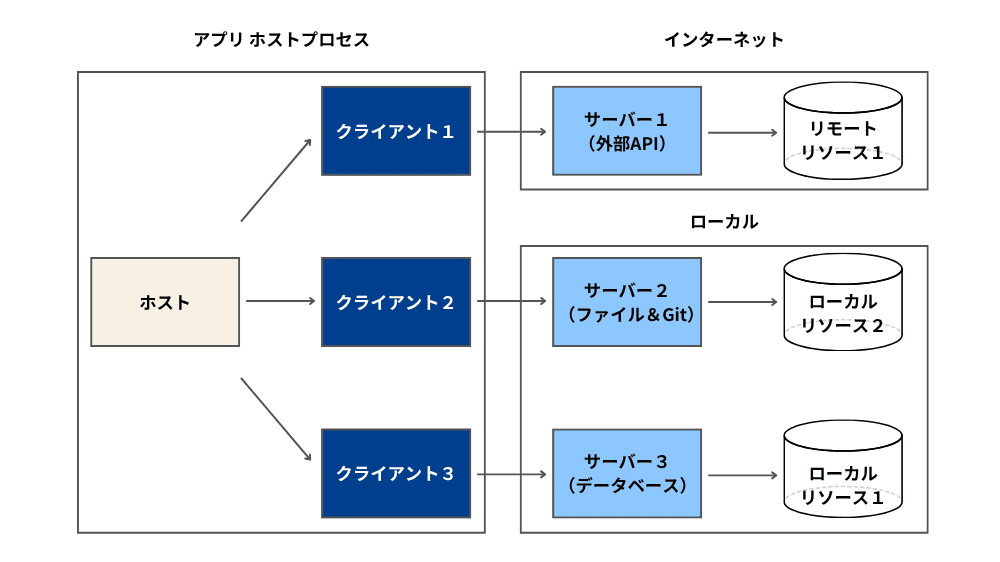

MCPのアーキテクチャはホスト、クライアント、サーバーという3つの役割に分かれ、これらが協力してデータ交換を行います。ホストはユーザーの指示を受け、MCPクライアントを通じてサーバーにリクエストを送信。サーバーは外部APIやローカル機能を実行し、その結果をホストに返すことで、AIアシスタントが複数のツールを1つのインターフェースで操作できます。

HTTPプロトコルがウェブサイト間で情報を交換するルールを提供するように、MCPは異なるAIモデルがデータソースやツールに標準化された方法で接続できるようにします。そのため、開発者は専用のインターフェースを作成せずに、複数のAIアプリケーションを構築できます。

LLMを使ったアプリケーション(チャットボットなど)は、正確で動的な回答を生成するために外部リソースに依存しています。これらのリソースは次の3つに分類できます。

- ツール:データベースへの問い合わせやメール送信など、LLMが実行するアクション

- リソース:文書やAPIの応答など、モデルが参照する構造化された情報

- プロンプト:事前に用意されたテンプレートで、対話の流れを導く

MCPの利便性と開発の効率化

外部リソースへのアクセスに標準化された仕組みがない場合、LLMアプリケーションは個別に統合しなければならず、開発が複雑化し、重複作業が発生します。MCPは、リソースを統一されたプロトコルで接続することで複数のLLMアプリケーション間での相互運用性を向上させます。開発者は、MCP互換のツールを使うことで、複雑な連携機能をゼロから作る必要がなくなります。

MCPの特徴

MCPの最大の特徴は、AIのワークフローに自然に溶け込む設計です。LLMエージェントが情報を取得し、推論し、行動を実行する仕組みに最適化されており、開発者がMCP対応のツールやデータソースを一度作成すれば、どのAIシステムでも即座に利用可能になります。

従来のAPI連携では、各AIツールごとに外部サービスとの連携を個別にカスタム実装する必要があり、サービスごとに認証処理やリクエスト形式が異なるため、システム間で再利用が難しくなります。しかし、MCPはこれらの非効率を解消し、ツールとデータ間のやり取りを標準化することで、開発作業の重複をなくします。開発者はMCP互換のツールを使うことで、複雑な連携機能をゼロから作る必要がなくなります。

MCPは、ユーザーがAIシステムを使用する際に直感的でスムーズな動作を提供し、コンテキストデータを効果的に活用するために重要な役割を果たします。コンテキストデータを標準化し、動的に配信することで、AIは幅広い統合環境でコンテキストデータを検出・交換し、シームレスに管理できるようになります。また、MCPは動的な環境や接続されたシステムに積極的に対応し、AIエージェントが最適なパフォーマンスを発揮するための基盤を提供します。

MCPのアーキテクチャ

MCPは、役割ごとに処理を分けることで、個別アプリケーションはデータ取得や外部アクションのための独自ロジックを実装せずに済み、異なるツールや環境にまたがった拡張が容易になります。また、役割分離により、クライアント側でアクセス制限を適切に管理したり、LLMに必要な情報だけを提供したりすることが可能となり、セキュリティと制御性も向上します。

MCPホスト

MCPホストは、LLMを組み込んだアプリケーションで、Claude Desktop、Cursorなどが代表例です。MCPホストでは、ユーザーにLLMとのやり取りのインターフェースを提供し、MCPクライアントを通じてMCPサーバーに接続、サーバーが提供するツールを利用してLLM機能を拡張します。ホストはデータ取得や実行処理を直接管理せず、クライアントに任せる役割を持っています。また、外部リソースに問い合わせを行ったり、ツールを実行したり、構造化されたプロンプトを使用したりするタイミングを決定します。

MCPクライアント

MCPクライアントは、LLMとMCPサーバーを繋ぐ仲介役です。クライアントは、LLMからのリクエストを受け取り、適切なMCPサーバーに転送し、結果をLLMに返します。また、ホストとMCPが提供する外部リソースの間でデータの流れやツールの実行を管理します。例えば、Claude Desktopでは、MCPクライアントが文書やAPIの結果、データベースのレコードなどのコンテキストを選択し、LLMのコンテキストウィンドウに注入します。

MCPサーバー

MCPサーバーは、LLMが使用するツールやデータアクセス機能を提供します。従来のリモートAPIサーバーとは異なり、MCPサーバーはローカルアプリケーションとして動作することも、リモートサーバーにデプロイされることも可能です。各MCPサーバーは、特定のツールセットを提供し、LLMがタスクを処理する際に必要なデータを取得して返します。サーバーはリソース(構造化データ)、ツール(外部アクション)、プロンプト(標準化されたインタラクションテンプレート)へのアクセスを提供します。

MCP導入のメリット

MCPには相互運用性の向上、柔軟性と拡張性、標準化によるエコシステムの形成という3つの主要なメリットがあります。開発者は効率的にAIアプリケーションを開発でき、未来の技術やツールにも柔軟に対応できます。

相互運用性の向上

最大のメリットは相互運用性の向上です。従来、M個のAIモデルとN個のツールを連携させるには、M×N通りの実装が必要でした。MCPは、この「M×N問題」を解決します。

開発者は、データソースやツールごとに一度MCPサーバーを構築すれば、MCPに対応したすべてのAIクライアント(アプリケーション)でそのサーバーを再利用できます。個別の開発や保守などの重複作業から解放され、アプリケーションのコア機能の開発に集中できるため、開発効率が大幅に向上します。

柔軟性と拡張性

MCPは、特定のLLMやベンダーに依存しないオープンなプロトコルであるため、開発者は利用するAIモデルを柔軟に切り替えることができます。また、アプリケーションに新しいツールやデータソースを追加したい場合も新たなMCPサーバーを接続するだけで済むため、拡張が容易になります。現在の断片的でスケーリングが困難な連携方式に代わり、持続可能なアーキテクチャを提供します。

標準化によるエコシステムの形成

MCPはオープンソースプロジェクトとして、仕様やSDK、構築済みサーバーなどが公開されており、誰でも開発に参加できます。開発者コミュニティーによる活発な貢献が期待され、対応するツールやデータソースのエコシステムが急速に拡大します。

多くの企業がサポートを表明しており、このエコシステムが成熟すれば、開発者は自らサーバーを構築せずとも、既存の豊富なコネクター群を活用して高度なAIアプリケーションを迅速に開発できるようになります。

MCPとRAGの違い

RAG(検索拡張生成)は、LLMが応答を生成する際に、外部の知識ソースから関連情報を検索し、その情報をプロンプトの一部としてLLMに与えることで、応答の精度や事実性を向上させる技術です。

RAGは、LLMにコンテキスト情報を付加する手法で、MCPと似ている部分もありますが、運用方法や適用範囲に違いがあります。どちらもコンテキスト情報を組み込んで、より的確で精度の高い結果を生み出しますが、RAGは主にウェブページやPDFなどの外部文書を活用したターゲット検索、非構造化データに最適です。

一方、MCPはCRMシステムや財務報告、企業データベースなど、大規模で構造化されたデータソースのデータ取得プロセスを効率的に管理します。MCPとRAGは補完的な特徴を持ち、連携して非常に効果的に機能します。例えば、MCPがCRMから構造化データを取得し、そのデータをRAGに提供します。RAGはそのデータと非構造化データ(顧客メール、サポートチャットログ、関連ニュース記事など)を一緒に処理します。AIシステムは構造化データと非構造化データを組み合わせ、ユーザーのニーズに最適な結果を提供します。

| 比較項目 | RAG | MCP |

| 主な目的 | 外部知識を検索し、LLMの応答の事実性・知識を補強する | LLMのコンテキスト全体(対話履歴、状態、外部知識等)を外部で管理する |

| 焦点 | 検索とその結果のプロンプトへの注入 | コンテキスト管理の仕組み・プロトコル全体 |

| 扱う情報 | 主に外部知識(文書、データベースなど) | 対話履歴、タスク状態、ユーザー情報、外部知識など広範なコンテキスト |

| 処理 | 質問ごとに知識を検索し、プロンプトに付加する | 対話全体を通じてコンテキストを動的に維持・更新・選択・提供する |

| 位置づけ | 比較的確立された具体的な技術 | より概念的、アーキテクチャ的なアプローチ |

| プロンプト長 | プロンプトが長くなる傾向 | プロンプト長を最適化・削減する可能性 |

RAGは「知識の検索と注入」に特化した技術であり、MCPは「コンテキスト全体の効率的な管理」を目指す、より広範な枠組みや考え方といえます。

MCP導入の際の注意事項

MCPの普及には課題が伴います。新しい技術標準の採用には時間がかかる上、既存システムとの統合にはコストがかかります。また、大手AI企業が独自の標準を推進する可能性もあり、業界全体での合意形成が求められます。

MCPを活用するには、開発者がプロトコルの仕様を理解し、適切に実装する必要がありますが、学習コストがかかるため、普及の速度に影響を与えるでしょう。MCPには課題もありますが、AIと既存システムの連携を効率化する実用的なツールとして、今後のソフトウェア開発において重要な役割を果たすことが期待されます。

セキュリティと信頼性を最優先に設計する

MCPは強力な機能を提供する一方でセキュリティリスクも伴います。特に、任意のコード実行やデータアクセスを許可するツールの実装には細心の注意が必要です。開発の初期段階から、ユーザーによる明示的な同意取得のフロー、最小権限の原則に基づいたアクセス制御、そして操作の透明性を確保するUI/UXの設計が不可欠です。

オープンなエコシステムを活用する

MCPの強みは、オープンソースで構築されるエコシステムにあります。自社のユースケースに必要なサーバーが既に公開されていないかどうか、まずは公式のサーバーリポジトリやコミュニティを確認することが開発の近道となります。また、自社で開発した汎用的なサーバーをコミュニティに公開し、貢献することで、エコシステム全体の発展に寄与できます。

スモールスタートで段階的に導入する

大規模なシステムにいきなり導入するのではなく、まずは開発者のローカル環境で試すことから始めましょう。Anthropicが提供するClaude Desktopアプリなどを利用すれば、既存のMCPサーバーを手軽にテストできます。小規模なユースケースでプロトタイプを作成し、MCPの有効性や技術的な課題を把握した上で、段階的に適用範囲を広げていくアプローチが成功の鍵となります。

最後に

MCPは、LLMと外部データソースやツールをシームレスに連携させ、開発者が効率的にアプリケーションを構築できる環境を提供します。MCPの最大の強みは、コンテキスト管理の効率化と標準化によって、開発作業の重複を削減し、相互運用性を向上させる点です。また、オープンソースで構築されたエコシステムを活用することで、開発者は他のツールと簡単に連携し、技術の進化に柔軟に対応することができます。MCPは今後のAIシステムの発展において、重要な役割を果たすことが期待されています。