リカレントニューラルネットワーク(RNN)とは、連続するデータを扱うディープラーニング技術で、時系列データや文章、音声といった連続的な情報を処理するために開発されました。通常のニューラルネットワークと異なり、RNNは過去の情報を保持しながら次の予測を行うため、過去の情報が現在や将来の予測に影響を与えやすいという特徴があります。

RNNの基本構造は入力層、隠れ層、出力層の3層から成り立ち、隠れ層が持つ記憶力によって過去の情報を保持しつつ処理を行うことで、自然言語処理や株価予測、音声認識などで優れた性能を発揮しています。しかし、RNNには長期依存性の問題や勾配消失問題、解釈性の低さといった課題も抱えています。近年では、LSTMやGRUなどの改良モデルが登場し、RNNの限界を補いながら多様な分野で応用が進んでいます。

リカレントニューラルネットワーク (RNN) とは

リカレントニューラルネットワーク(RNN:Recurrent Neural Network、回帰型ニューラルネットワーク)は、ディープラーニングの一種で、シーケンシャルデータ(単語や文、時系列データなどの連続的なデータ)を扱う際に特に効果的なネットワーク構造です。RNNは連続的な関係性をモデル化するため、以前に受け取った情報を保持しながら新しい情報を処理し、データの連続性を活かして次の予測を行います。

RNNは、ディープニューラルネットワーク(DNN)に分類され、通常のニューラルネットワークが中間層を1つ持つのに対し、DNNでは複数の中間層が設けられています。データの特徴をより複雑に捉えることができるため、音声認識や機械翻訳、株価予測など、時系列データや自然言語処理が必要な分野で高いパフォーマンスを発揮します。

RNNの構造は入力層、隠れ層、出力層の3つの層から成り立っています。入力層はデータを受け取り、出力層で処理結果が得られます。隠れ層はその間に位置し、入力データを分析・処理し、出力層へ送る前に情報を保持します。この隠れ層が持つ記憶力により、過去のデータが次の予測に影響を与える仕組みが形成されます。記憶力を持つことにより文章や音声、動画などのシーケンシャルデータに対して、前後の流れを把握した精度の高い処理が可能です。

RNNの特徴は、多様な分野での応用、時系列データ処理の優位性、長期依存関係の学習能力、パラメータの共有が挙げられます。

RNNは自然言語処理、音声認識、画像分析、機械翻訳などの分野で高いパフォーマンスを発揮します。特に、株価予測や動画解析といった時系列予測を必要とするタスクにも適しており、他のニューラルネットワークと組み合わせることで、さらなる精度向上が期待されるためRNNを活用したサービスやシステムの開発が進んでいます。

時系列データ処理において、RNNは入力層、隠れ層、出力層の3層構造を持ち、隠れ層が循環構造を形成しています。この循環構造により、過去の情報を保持しつつ新しいデータを効率的に処理でき、株価予測や動画解析などに対応可能です。

RNNは長期依存関係の学習が難しいという課題も抱えていますが、改良版であるLSTM(Long Short-Term Memory)やGRU(Gated Recurrent Unit)などと組み合わせることで、長い文章や複雑なシーケンスデータの長期的な依存関係も効率的に学習可能です。RNNの性能がさらに向上し、長い文脈や過去の情報を考慮した予測が実現します。

また、RNNではパラメータ共有の特徴があり、同じパラメータを異なる時刻で共有することで、必要最小限のパラメータでデータを効率的に学習・処理します。パラメータの増加を抑制しながらも、異なる時刻のデータに対する学習が進められるため、メモリ効率が向上し、スムーズな時系列データ処理が可能になります。

リカレントニューラルネットワークの仕組み

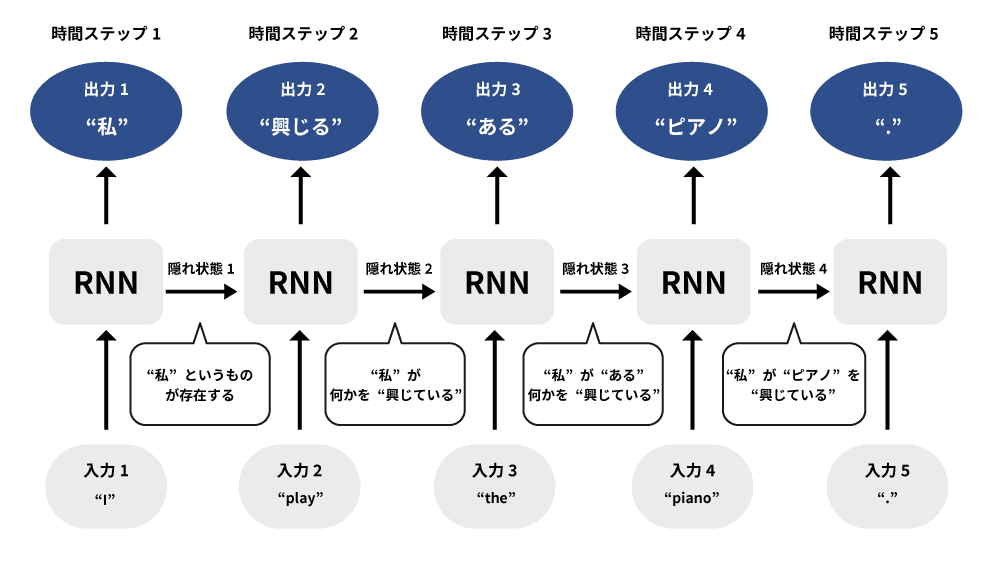

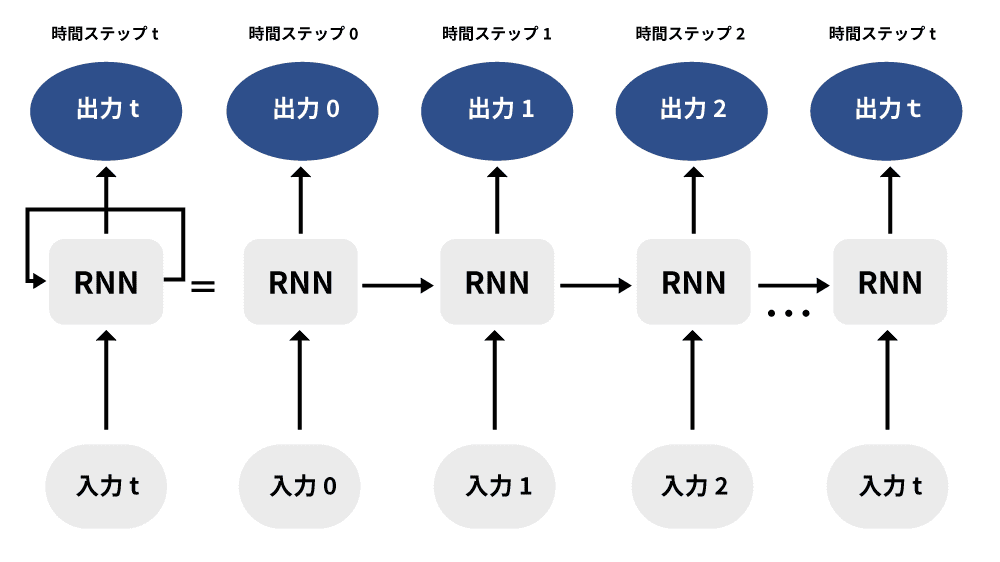

リカレントニューラルネットワーク(RNN)は過去の情報を活用し、現在の入力に基づいて将来の出力を予測するディープラーニングモデルです。このネットワーク構造の特徴は、入力層、隠れ層、出力層の3層で構成されることと、隠れ層におけるループ構造の存在です。このループ構造により過去の情報が隠れ層で保存され、次のステップで利用されるため、時系列データや連続的なデータの処理に適しています。

RNNでは、隠れ層が時系列予測において重要な役割を担います。隠れ層のループ構造により、過去の情報を保持したまま、新しい情報を処理することが可能です。入力層から受け取ったデータが隠れ層で処理され、その結果が出力層に送られると同時に、隠れ層の出力は再び隠れ層に戻され、繰り返し計算が行われます。

隠れ層の出力を入力層や出力層へ伝播するディープニューラルネットワーク(DNN)とは異なり、同じ隠れ層が再帰的に用いられる構造が特徴です。DNNでは、層ごとに順次データが伝播され、各層の結果が次の層に伝えられますが、RNNでは隠れ層の出力が再度自身に戻されるため、連続する情報を保持しやすく、シーケンシャルなデータの処理に適しています。

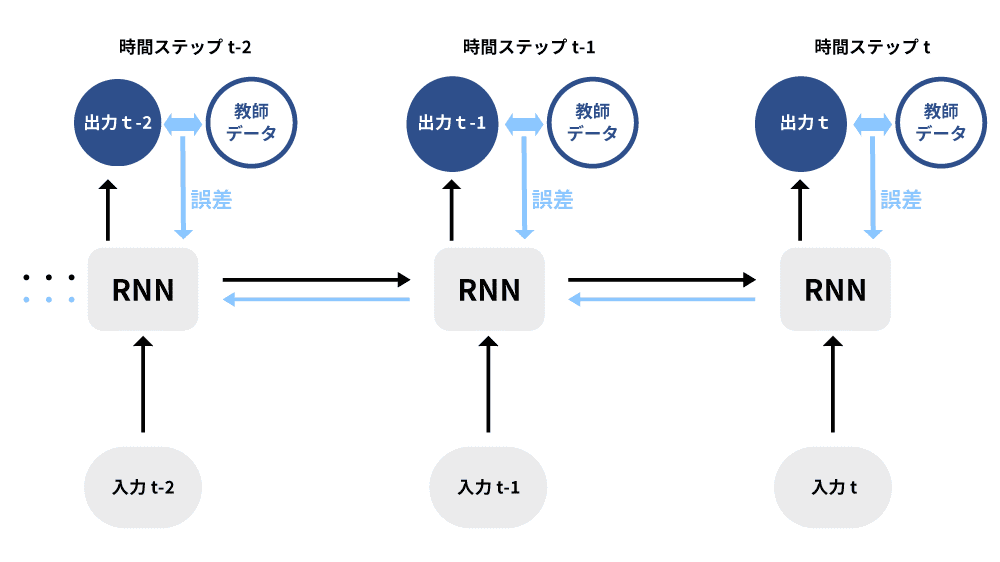

さらに、RNNには隠れ層と入力用の2種類の重みが存在し、学習の際にはそれぞれの重みが調整されます。隠れ状態ベクトルに保持された情報は、次のタイムステップ(h1,2,,,t)で新たな入力に結びつけられ、予測精度が向上します。RNNのセルを展開してみると、各タイムステップで隠れ状態がどのように機能するかがわかります。過去の入力に基づいた隠れ状態が現在の出力に影響を与え、出力が生成されると同時に、その隠れ状態が次のタイムステップに渡されます。

このように、隠れ層の再帰構造により、RNNは時系列データや自然言語など、連続的で順序が重要なデータに対して高い適応力を発揮します。隠れ層のループを用いた構造によって、RNNは過去の情報を保持しつつ、新しい情報を適切に反映させるネットワークモデルとなっています。

BPTT

BPTT(Backpropagation Through Time)は、RNNの学習アルゴリズムの一種です。ニューラルネットワークの重み(パラメーター)を調整する手法としては誤差逆伝播法(Backpropagation)がありますが、時系列データ処理であるRNNに適応し、時間方向に拡張したものをBPTTと呼びます。このアルゴリズムでは、過去の情報を考慮しながら現在の出力に対する誤差を逆伝播させるため、RNNの重みが効率的に更新され、長期的な依存関係も学習可能です。

BPTTのプロセスは主に順伝播、誤差計算、逆伝播の3つのステップで構成され、この一連の計算フローにより、各タイムステップで隠れ層の重みが調整され、RNNが時系列の関係性を捉えられるようになります。

LSTM (長・短期記憶)

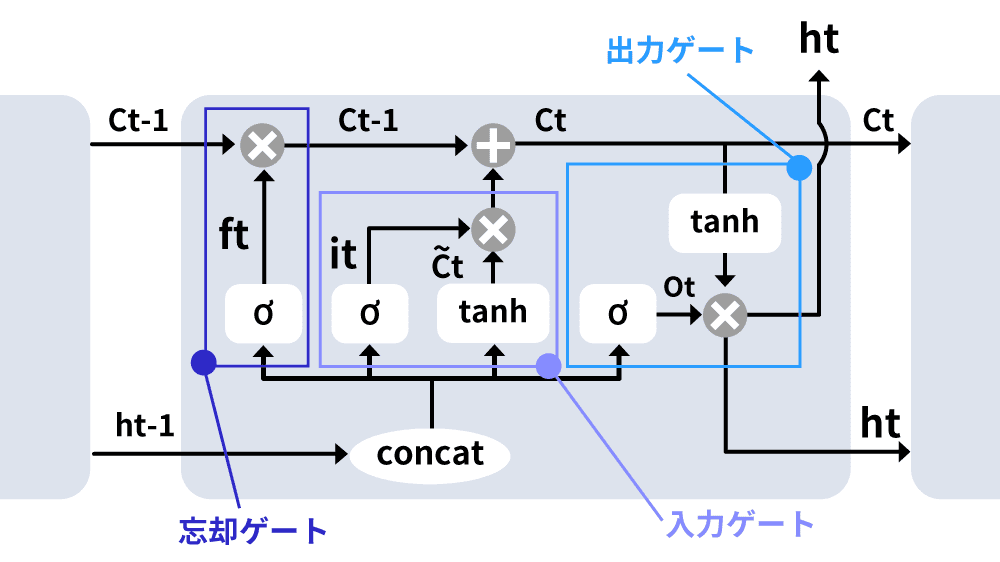

LSTM(Long Short-Term Memory)はRNNの一種であり、特に長期的な依存関係を効果的に学習するために設計されたモデルです。通常のRNNは時間が経つにつれ勾配が極端に小さくなる勾配消失(学習が進まなくなる)や非常に大きくなる勾配爆発(極端な学習結果となる)といった問題を抱えており、長期的なデータ依存性の学習を困難にします。この課題を解決するために、LSTMには独自のゲート構造が追加され、必要な情報を保持しつつ不要な情報を除去できる仕組みが導入されています。

LSTMは3つのゲート(入力ゲート、忘却ゲート、出力ゲート)によって、情報の取捨選択を行います。入力ゲートは新しい情報を取り込むかを制御し、忘却ゲートは過去の情報を保持するかを決定します。出力ゲートは隠れ層に保持された情報を次のタイムステップや出力に利用するかを管理します。このゲート機能により、LSTMは長期的な情報を効果的に保存し、必要に応じて利用することで、長期依存関係のあるデータを扱いやすくしています。

リカレントニューラルネットワークの利用用途

信号処理

信号処理の分野では、RNNやその派生モデルが広く利用されています。信号データはセンサーから時間に沿って連続的に収集されることが多く、シーケンシャルデータとして扱うのに適しているためです。これにより、RNNを用いた大規模な信号データの自動分類や自動回帰が可能となり、リアルタイムでの予測や異常検知が実現できます。

また、信号データをRNNに入力する前に、特徴抽出のための前処理を行うことも一般的です。例えば、周波数成分など特定の特徴に基づいたデータを抽出して入力することで、ネットワークの性能が向上します。信号の特徴を効率的に抽出し、RNNに入力することで、より精度の高い予測が可能になります。

文章解析

文章解析分野では、RNNが自然言語の連続的な構造を学習するため、テキスト分類、テキスト生成、機械翻訳、感情分析といった自然言語処理(NLP)タスクで効果を発揮します。言語はもともと逐次的であり、単語やフレーズが前後の文脈に依存するため、RNNはその連続性を活用して、単語やフレーズを文脈に当てはめながら適切な予測が可能です。

例えば、RNNを用いたAIは、日本語や英語で書かれた文章を解析し、その内容を認識・分類できます。ニュース記事を入力して、内容に基づいて「政治」「芸能」「スポーツ」などのカテゴリに分類することが可能です。また、チャットボットにもRNN技術が応用され、ユーザーからの質問文を解析して内容に応じた案内を提供します。

文章生成

RNNは、文章の解析に加えて新たな文章を生成する用途にも優れています。RNNに大量のテキストデータを学習させると、文章内の単語の出現パターンをモデル化できるため、ある単語の後に続く可能性が高い単語を予測することが可能です。この予測能力により、人間が書いたかのような自然な文章を自動で生成できます。

応用として、テーマに沿ったコラムの自動作成、メールの文章作成、既存の文章の要約生成などが挙げられます。営業メールや顧客対応のメッセージも、自動生成されるため、業務の効率化にも役立ちます。

機械翻訳

RNNはGoogle翻訳などのアプリケーションに広く活用されており、異なる言語間で自然な翻訳が可能です。RNNを利用したニューラル機械翻訳(NMT)技術は、従来の翻訳技術よりも、文脈を理解した自然な言い回しで言語を変換できます。このため、RNNベースの翻訳システムは多くのユーザーに親しまれており、日常的に利用されています。

RNNによる機械翻訳は、言語モデルのようにシーケンシャルな文章処理を行いますが、翻訳タスク特有の処理フローも備えています。たとえば、言語モデルが直前の単語に基づいて次の単語を予測するのに対し、機械翻訳では元の文章(ソース言語)の全体を読み込んでから翻訳を開始します。このため、翻訳文の最初の言葉から文章全体の情報が反映され、より文脈に即した正確な翻訳が可能です。

画像解析

RNNは、画像解析の分野でもCNN(畳み込みニューラルネットワーク)と組み合わせて活用されています。CNNは画像の静的な特徴を抽出することに優れていますが、RNNはその情報から文脈を捉え、説明文を生成する役割を担います。この技術を用いると画像から自動で説明文を生成したり、画像内のオブジェクトやアクションを詳細に説明したりすることが可能です。

RNNによる画像解析は、手書き文字の読み取りや、画像内テキストの抽出など、さらに応用範囲を広げています。RNNは文章のようなシーケンシャルなデータの処理を得意としており、画像データの連続性や構造を文脈に沿って処理することも可能です。

音声認識

RNNは音声認識技術においても重要な役割を担っており、多くのスマートスピーカーに活用されています。音声データは時系列的な性質を持つため、RNNのシーケンシャルなデータ処理能力がその特性に適しています。RNNは発話された単語だけでなく文脈も考慮し、前後の関係を理解しながら音声をテキストへと変換するため、スマートスピーカーが自然な会話を認識し、高い精度で応答することが可能です。

リカレントニューラルネットワークの課題

長期依存性の問題

RNNは過去の情報を保持し、長期的な依存関係を学習する能力を持っていますが、実際には「勾配消失問題」や「勾配爆発問題」が発生しやすく、特にシーケンスが長くなるほど、初期の情報を保持し続けることが難しくなります。このため、シーケンスの始めにある情報が後続の予測に影響を及ぼすべき場面でも、正確に学習されない場合が多いのです。

長期依存性の問題はシーケンスが長い場合に顕著であり、長文の自然言語処理や長期間にわたる時系列予測などでRNNの性能に制約が生じる原因となります。

勾配消失問題

RNNにおける勾配消失問題は、時系列データや自然言語処理において、過去の情報を学習し続けるうちに発生する課題です。RNNは過去の情報を時点を遡って伝播させる特性を持ちますが、この逆伝播の過程で勾配が急速に小さくなり、ほぼゼロに近づいてしまうことがあります。特にネットワークが深くなると、初期の層に伝えられるべき重要な情報が失われ、学習が停滞する原因となります。

この状態になると、シーケンスの長期的な依存関係を学習することが困難になり、RNNが長期記憶を保つのが難しくなるのです。この勾配消失問題は、RNNが長い文脈や時系列データのパターンを十分に学習することを妨げるため、結果として予測精度が低下します。

なお、LSTM(Long Short-Term Memory)やGRU(Gated Recurrent Unit)などの改良モデルは勾配消失問題を解決するために開発されました。

解釈性が低い

RNNには解釈性が低いという課題があり、これは機械学習やディープラーニング分野で幅広く利用される一方で、特に問題視されている点の1つです。

RNNは時系列データを処理するために複雑な構造を持っており、この構造が原因で、出力結果がどのような仕組みで生成されたかを人間が理解しにくくなります。解釈性の低さはRNNの結果に対する説明が必要な医療診断や金融取引といった分野で問題になることが多く、改良の余地がある点とされています。

最後に

リカレントニューラルネットワーク(RNN)は過去の情報を活用して連続的なデータを処理するディープラーニング技術であり、時系列データや自然言語処理、音声認識など、連続性が重要なタスクに強みを発揮します。RNNは特有のループ構造を持つ隠れ層によって、データの文脈を保持しながら予測を行うことができるため応用範囲は幅広く、自然な言語生成や音声認識、機械翻訳、画像解析などに用いられ、様々な業界で利用が進んでいます。

しかし、長期的な依存関係の学習には課題があり、勾配消失や解釈性の低さといった技術的な制約もあります。これらの課題を補完するために、LSTMやGRUといった改良モデルが開発され、RNNの性能と応用範囲がさらに拡大しています。