機械学習のデータセットとは、モデルを訓練し、性能を評価するために必要なデータの集合体を指します。データセットには、テキストや画像、音声など多様な形式が含まれており、目的に応じて適切なものを選択することが重要です。トレーニングセットやバリデーションセット、テストセットといった異なる役割を持つデータを活用することで精度の高いモデルを構築できます。また、データの質を高めるためには、収集や整形、管理のプロセスが欠かせません。適切なデータセットを選び、運用することで、機械学習の効果を最大化することが可能です。

機械学習のデータセットとは

データセットとは、機械学習やデータ解析において利用されるデータの集合体を指します。特定のタスクや問題に関連する情報を含んでおり、観測値や事例の集まりとして構成され、それぞれが複数の特徴や属性を持ち、用途に応じて多様な形式をとります。たとえば、テキストデータセットは自然言語処理タスク向けの文章や文の集合を表し、音声データセットは音声認識や音声処理のための音声ファイルの集合を意味します。

機械学習においては、企業が独自のデータを構築するために、質と量の両方が揃ったデータセットを活用することが欠かせません。学習結果の精度はデータの質や量に大きく依存するため、適切なデータの選定と管理が重要です。

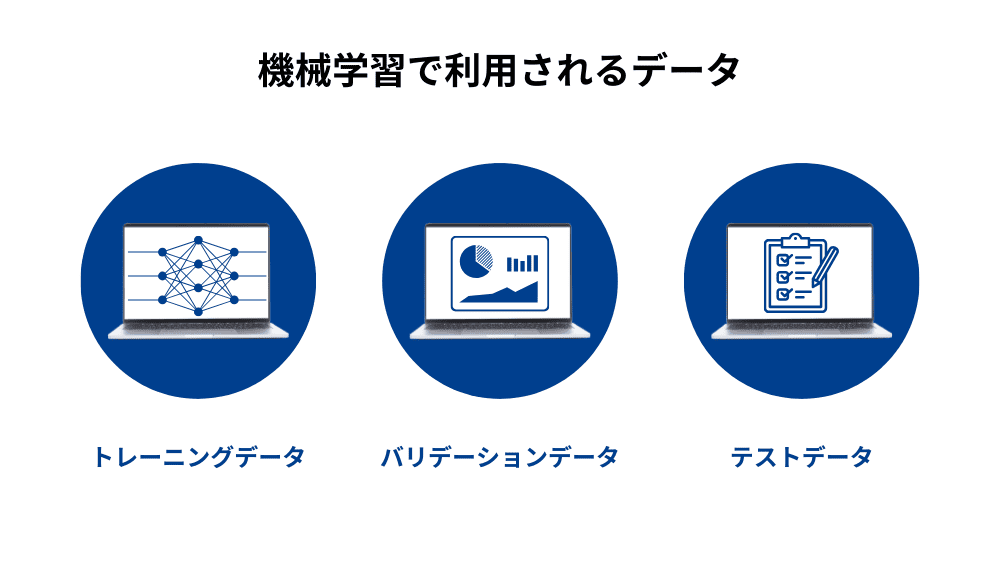

機械学習で用いられるデータセットは、通常以下の3種類に分けられます。

- トレーニングセット:モデルを学習させるためのデータセットで、全体の半数以上を占めることが一般的です。このデータを使ってモデルのパラメータが調整されます。

- バリデーションセット:トレーニングセットで調整したモデルの性能を評価し、ハイパーパラメータ(モデルの学習プロセスを制御するパラメーター)の調整に使用されます。学習は行わず、最適なパラメータ設定を見つけるために役立ちます。

- テストセット:最終的にモデルの精度を評価するために使用されるデータセットです。これを用いることで、実際の運用環境でのモデルの性能を検証します。

また、データセットの質を高めるためには、データクレンジングが不可欠です。重複データや誤記、表記の揺れなどを修正し、処理しやすい状態に整えることで、学習モデルの性能を最大化します。ネガティブサンプルの活用も重要です。たとえば、顔認証では人物とそれ以外の物体を区別するデータが必要です。このようなネガティブサンプルを含むデータセットを使用することで、モデルの汎化性能を向上させることができます。

データセットの入手方法

データセットの作成には、独自収集、外部委託、オープンデータの活用といったさまざまな方法があります。プロジェクトの要件やリソースに応じて、最適な手法を選ぶことで、効率的に質の高いデータを集めることができます。それぞれの手法にはメリットとデメリットがあるため、目的に応じた判断が求められます。

独自にデータを収集する方法

自分でデータを収集し、整形してデータセットを作成する方法では、特定のプロジェクトや課題に最適なデータを得ることが可能です。ビジネスプロセスのログ、ユーザーのアンケート回答、実験結果など、手元にあるデータを利用してデータセットを構築できます。たとえば、アンケート調査を行うことで、プロジェクトに必要なデータを独自に収集できます。費用を抑えられる反面、時間と手間がかかる点に注意が必要です。

独自に収集したデータを効率よく整理するためには、以下の点を意識するようにしてください。

- CSV形式でデータを作成:Excelで管理する場合、CSV形式を利用することでデータの確認や修正が容易になります。

- シンプルなデータ構造:サンプルを縦、特徴量を横に並べるなど、わかりやすい形式で整理します。

- セル結合を避ける:データの読み込みをスムーズにするため、セル結合は使用しないようにします。

外部にデータ収集を依頼する方法

データ収集が難しい場合、外部の専門家やサービスに依頼することも可能です。一部のデータベンダーやオンラインプラットフォームは調査データや市場データ、統計データなどの多様な種類のデータセットを提供しています。

外部に依頼することで社内工数を大幅に削減できます。クラウドソーシングを活用したり、信頼性の高いデータを提供する専門会社に依頼したりする方法が考えられますが、コストがかかるため、事前に費用対効果を検討することが重要です。また、購入したデータセットを利用する際は、そのデータが目的に適しているかを十分に確認する必要があります。

オープンデータセットの活用

インターネット上で公開されているオープンデータを利用するのも有効な手段です。政府や研究機関が公開しているオープンデータには動画、画像、テキストデータなど多様な形式のデータがありますので、社内の作業負担を減らしながら質の高いデータを入手できます。

Webスクレイピングを活用すれば公開されているウェブページから効率よくデータを収集できます。ただし、この手法を用いる際は法的制約や倫理的な観点に注意する必要があります。オープンデータの中には商用利用に制限があるものもあるため、利用規約を事前に確認することは必須です。

データセットの作り方

目的・課題・仮説の明確化

機械学習プロジェクトを成功させるためには、解決すべき課題とその目的を明確にすることが重要です。たとえば、業務効率化を目指して特定の作業を自動化したり、製品需要を予測して仕入れの最適化を図るといった具体的な目標を設定します。課題を具体化することで必要なデータの種類や収集方法が明確になります。また、機械学習の導入によって得られる結果を分析するために、仮説を立てておくことも大切です。

データの収集

目的が明確になったら実際にデータ収集に取り掛かります。データ収集にはアンケートや実験、Webスクレイピングなどさまざまな手法があります。必要に応じて信頼できるサイトからデータを取得することで大量かつ高品質なデータを効率よく収集できます。ただし、収集したデータが不十分であるとモデルが訓練データには適応するものの、新しいデータに対して正しく予測できないオーバーフィッティング(過学習)のリスクが生じます。オーバーフィッティングを防ぐためにはデータの量を段階的に増やすことが求められます。

教師あり学習を行う際には収集したデータにアノテーションを付与します(データに正解ラベルを追加する作業でモデルが正確に学習できるようになる)。データを整形する際には整然データ(Tidy data)を意識してください。整然データとは以下の条件を満たしたデータです。

- 各セルに1つのデータ

- 各列が1つの変数を表す

- 各行が1つの観測を表す

- 観測ユニットの類型が1つの表で表現される

データの加工

データ収集後は分析やモデル学習に適した形式にデータを整形する必要があります。具体的には、欠損値の処理、ダミー変数化、外れ値の除去といった前処理を行います。

- 欠損値の処理:欠損した値を補完するか、欠損を含むサンプルを削除します。

- ダミー変数化:数値化できないカテゴリデータを数値に変換し、統計解析を可能にします。

- 外れ値・異常値の除去:データ分布から大きく外れた値を確認し、必要に応じて除去します。

適切な前処理を行うことで、モデルの精度が向上し、信頼性の高い結果を得ることができます。

トレーニングセットとテストセットへの分割

データの前処理が完了したらトレーニングセットとテストセットに分割します。トレーニングセットはモデルの学習に使用され、テストセットは学習済みモデルの性能を評価するために使用されます。一般的に、トレーニングセットとテストセットの比率は7:3または8:2が適切とされています。この分割により、モデルの汎化性能を確認し、実運用時の精度を高めることができます。

データセットを使う時の注意点

自社に適したデータセットを選ぶ

データセットにはさまざまな種類があるため、目的や用途に応じて適切なものを選ぶ必要があります。選択を誤ると期待する機械学習アルゴリズムを実現できなくなる可能性があります。また、性能向上のためには平均的なデータを用いることが重要です。データが偏っているとモデルの汎化性能が低下し、現実のデータに対する適応力が不足するリスクが生じます。

使用しないデータは排除する

データセットを作成する際には実際に使用するデータを適切に選別する必要があります。不要なデータが含まれていると解析の精度が低下し、結果として誤った結論を導く可能性があります。特に検証段階で問題が発生しやすいため、使用しないデータは早期に排除し、効率的なデータセットの構築を心がけましょう。

完成後も検証や改善を行う

データセットは一度完成しただけでは十分ではありません。使用を重ねる中で発見される問題点を改善し、定期的に見直すことが重要です。モデルの精度を向上させるためにもデータセットの定期的な検証と更新を行い、常に最新の状況に対応できるようにしてください。

データセットの被覆性と均一性

機械学習モデルの性能を最大化するためには、データセットが多様な状況を網羅していることが求められます。これをデータセットの被覆性と呼びます。また、均一性も重要で、データセット内の各ケースの発生頻度が偏っていないことが理想です。均一性を確保しながら稀なケースについても十分なデータ量を用意することで、バランスの取れたモデルが構築できます。

バイアスやノイズを排除する

収集したデータに特定のバイアスが含まれるとモデルの性能に悪影響を及ぼします。データ収集時の環境や方法に注意を払い、偏りを最小限に抑えることが重要です。また、ノイズが含まれているデータは適宜除去し、機械学習に適したクリーンなデータセットを作成ってください。具体的には、欠損値の処理や外れ値の除去といった前処理が求められます。

データの形式と管理

データセットはCSV形式で保存すると解析や修正が容易になります。ファイル名や変数名には一定のルールを設け、Excelでデータを管理する際にはセルの統合を避け、空のセルの意味を統一するなどの工夫が必要です。

著作権に注意する

データセットを作成する際には、著作権を含む法的な側面に注意を払う必要があります。無断で著作権保護されたデータを使用すると、法的リスクが生じる可能性があります。オープンソースデータセットを利用する場合でも、ライセンスや使用条件を確認し、遵守することが重要です。特に商用利用を検討する際には、法務担当者に相談するなど慎重な対応が求められます。

機械学習のデータセットサイト

【データセット検索サイト】

【データセット総合掲載サイト】

- 国立情報学研究データリポジトリ

- Link Data

- Harvard Dataverse(ハーバード大学)

- TensorFlow Datasets

- HuggingFace Dataset

- UCI Machine Learning Repository(カリフォルニア大学)

- e-Govデータポータル(デジタル庁)

- BigQueryの一般公開データセット(Google)

【画像のおすすめデータセット】

【動画のおすすめデータセット】

- YouTube-8M

- YouTube-BoundingBoxes Dataset

- Moments in Time Dataset(MIT、IBM)

- AVA(Google)

- BDD100K(カリフォルニア大学)

【テキスト・文章データのおすすめデータセット】

- 自然言語処理のためのリソース(京都大学)

- 日本語対訳データ

- 青空文庫

- Googleブックス

- クックパッドデータセット(国立情報学研究所)

- ニコニコデータセット(国立情報学研究所)

- Wiki-40B(Google)

【音声データのおすすめデータセット】

最後に

機械学習のデータセットとはモデルの性能を左右する重要な要素であり、その作成や管理には多くの配慮が必要です。目的に合ったデータを収集し、適切に加工・整形することで、モデルの汎化性能を向上させることができます。データの被覆性や均一性、バイアスの排除といった要素も重要ですが、同時に著作権を含む法的側面への配慮も欠かせません。データセットの質を継続的に見直し、改善を重ねることで、長期的に高いパフォーマンスを維持できるモデルを構築することが可能です。