Sakana AIは、AI技術の開発をAI自身が自動化するというビジョンのもと、新たな技術「AI CUDA Engineer」を発表しました。これは、AI開発の基本言語であるPyTorchのコードを自動的に最適化されたCUDAカーネルへ変換し(GPUを稼働させる言語)、AIの計算速度を劇的に向上させるエージェントフレームワークです。AIがAIの計算を加速する本開発ですが、海外のLLM開発界隈で論文の質を疑問視する声もあがっています。

The AI CUDA Engineerとは

現代のAIは、GPUを活用した並列計算に大きく依存していますが、その計算コストは年々増大しています。Sakana AIは、AIの効率を向上させる最善の方法は、AI自身がAIの最適化を行うことだと考え、「AI CUDA Engineer」を開発しました。

CUDAはNVIDIAのGPU向けプログラムの標準技術であり、その中核となるCUDAカーネルを最適化することで、AIの学習や推論の処理を加速できます。「AI CUDA Engineer」は、AI開発の基本言語であるPyTorchのコードを解析し、進化的アルゴリズムを用いて最適なCUDAカーネルを自動生成します(=GPUを稼働させる言語へ変換する)。この技術により、10〜100倍の高速化を実現し、場合によっては既存のCUDAカーネルより最大500%高速なカーネルを作成できるといいます。

エージェントフレームワークの概要

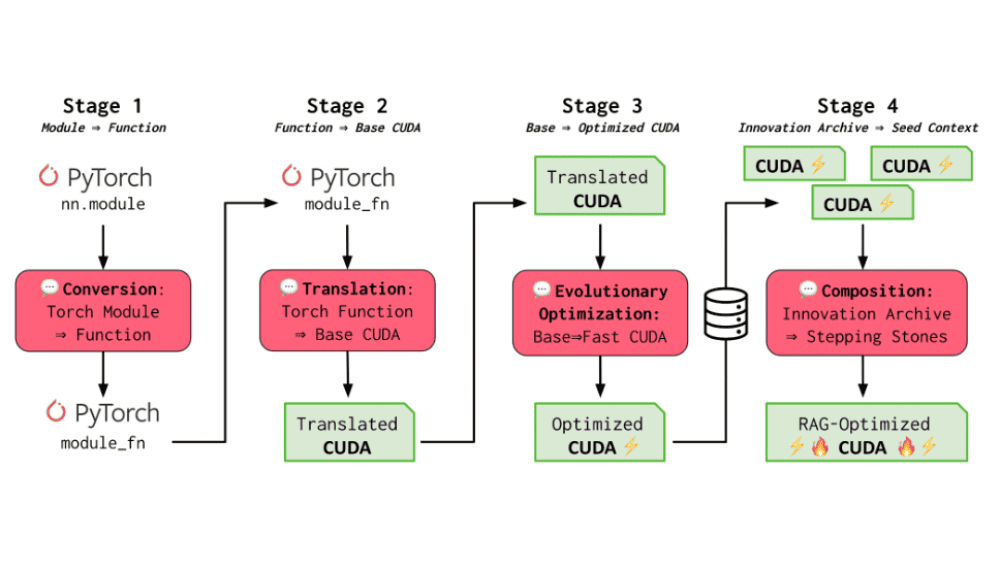

AI CUDA Engineerは、4つのステップを経てCUDAカーネルを最適化します。まず、PyTorchコードをCUDAカーネルへ変換し、基本的な動作を確認します。次に、進化的最適化を導入し、「適者生存」の手法を用いて最も効率的なカーネルを生成します。さらに、既存のカーネル同士を組み合わせて新たなカーネルを生み出し、最終的には最適なカーネルをアーカイブして、今後の最適化に活用する仕組みとなっています。このアプローチにより、機械学習モデル全体をCUDAカーネルベースの最適化システムへと変換することが可能になります。

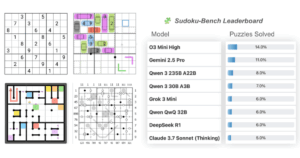

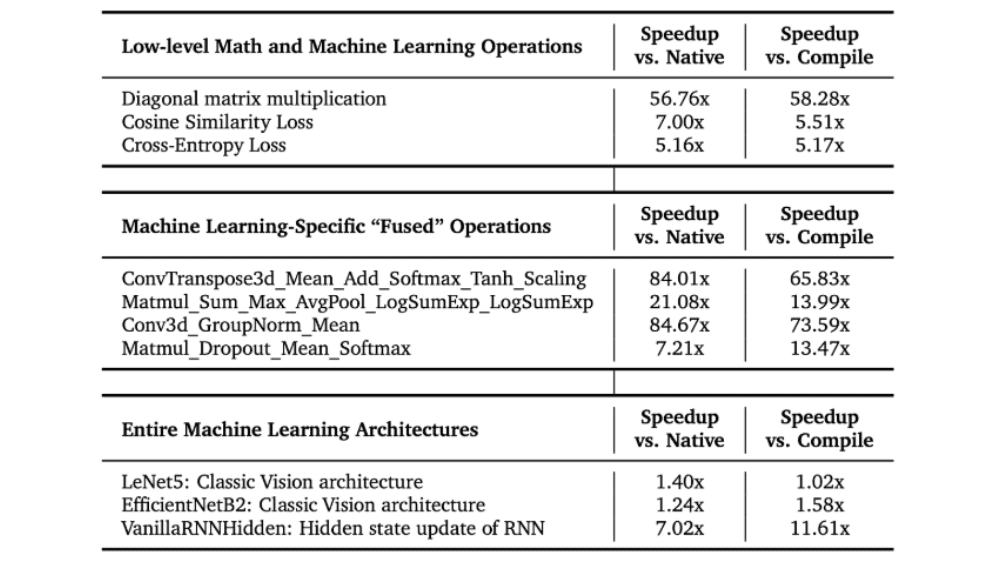

Sakana AIによると、AI CUDA Engineerを用いた最適化により、PyTorchの標準コードと比較して圧倒的な性能向上が確認されました。PyTorchネイティブのコードと比較して10〜100倍の速度向上が見られ、さらに、多くの既存のCUDAカーネルと比較しても最大500%の高速化を実現するケースがあったといいます。また、機械学習に関連する229のタスクのうち、81%でPyTorchの実行時間を短縮し、生成したCUDAカーネルの20%はPyTorchの標準実装の2倍以上の速度を達成しました。この手法により、行列積算やディープラーニング演算のCUDAカーネルが効率化され、Sakana AIのベンチマークでは最高水準の性能を記録しました。

Sakana AIは、AI技術の計算効率を100万倍向上させるという長期的な目標を掲げています。AIの発展が続く中、計算コストの増加は大きな課題であり、持続可能なAI開発のためには、効率的なハードウェア活用が不可欠です。AI CUDA Engineerは、AIシステムがより省エネルギーで高速に動作する未来を実現するための重要なステップであり、今後さらなる最適化が進むことが期待されています。また、Sakana AIは「AI CUDA Engineer」が生成した30,000個以上のCUDAカーネルをオープンデータセットとして公開しました。

「AI CUDA Engineer」について一言

Sakana AIは、日本を拠点にAI技術の最前線を開拓し続けています。特に、自然界の法則にインスパイアされた研究開発を行っており、その先進性と特異性から、極めて示唆深い情報を提供している企業です。これまで界隈に大きな衝撃を与えた「AI Scientist」は、AI研究開発プロセスの自動化というソフトウェア的なアプローチを取っていました。しかし、今回のAI CUDA Engineerは、単なるソフトウェアの改良にとどまらず、GPUを効率的に活用する技術の開発という意味で、よりハードウェアに近い領域に踏み込んでいます。

NVIDIAのGPUは、CUDAという専用のプログラミング言語を用いて制御されていますが、AI開発の主流言語であるPyTorchとの親和性が低く、パフォーマンスを最大限に発揮するには手作業での調整が必要でした。AI CUDA Engineerは、このCUDAの調整をAIが自動で行うことで、高度な最適化を実現し、結果として10〜100倍という圧倒的な処理速度の向上を達成したとしています。

大変素晴らしい成果ではありますが、実はこの論文はLLMの研究者の疑義の声もが上がっているようです。こちらのGeminiの開発者によるポストでは、研究開発企業でありながら、単純な内容であり、かつ簡単な検証が漏れ内容に不正確な点が多い、と指摘されています。この論部については、今後の評価に注目していこうと思います。