ブラックボックスとなっているディープラーニング技術の解釈性向上は、AI開発において大きな可能性を持っています。AIモデルの内部構造理解では、t-SNEやUMAPといった次元削減による二次元可視化手法が一般的でしたが、データ構造を歪めてしまう(極度に単純化してしまう)という課題がありました。九州大学の研究チームが開発した「k*Distribution」は、データ構造の歪みを抑制しつつ、ニューラルネットワークの内部構造をこれまでにない精度で可視化する手法を開発しました。

AIの新解釈手法「k*Distribution」の概要

AIモデルの内部構造を理解するための可視化技術として、t-SNEやUMAPが広く用いられています。これらの手法は高次元データを低次元空間に変換し、人間が視覚的に理解しやすい形式でデータの関係性を示します。t-SNE (t-Distributed Stochastic Neighbor Embedding)は2008年に提案された手法で局所構造の保持に優れている反面、計算コストが高く、全体構造の理解に乏しい手法でした。2018年に、全体構造の理解、計算コストを改善させた手法としてUMAP (Uniform Manifold Approximation and Projection)が提案されましたが、ニューラルネットワークがどのようにデータを整理しているかを完全に把握するには不十分であり、重要な詳細が失われる可能性がありました。

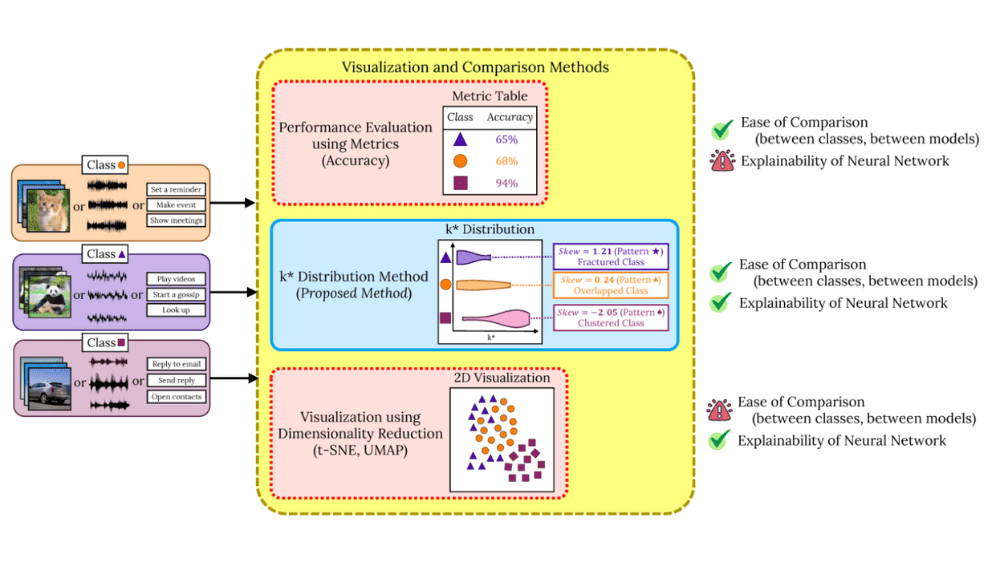

九州大学の研究チームは、従来手法の課題を克服し、ニューラルネットワークがデータをどのように整理し処理しているかをより正確に視覚化する手法としてk*Distributionを開発しました。この手法は、AIの内部動作の解釈性を向上させることで、信頼性の高いAIモデルの構築を目指しています。k*Distributionでは従来手法では難しかったデータ構造の歪みを抑制しつつ、異なるデータグループ間の関係性を視覚的に表示します。データの重なり具合によって「分断型」「重複型」「クラスター型」の3つの区分でモデルを可視化します。

次の図表はAIモデルの可視化手法を比較しています。異なる画像やチャート、テキストなどを分類した結果(左)に対し、AIモデルの解釈が中央に示されています。メトリックス法(中央上)は単純なモデルの評価結果を示しています。t-SNEやUMAPといった二次元可視化手法(中央下)は多次元のデータ構造を2次元まで次元削減され可視化したものです。主題であるk*Distributionは中央中段に示されており、3つのクラスが「分断型(分散しすぎており括りづらい)」「重複型(異なるクラスで重複している)」「クラスター型(明確に切り分けられている)」であることが明示されています。

「k*Distribution」について一言

AIモデルはブラックボックスと言いますが、モデル性能の改善や倫理的な責任などのいくつかの観点から解釈可能性が求められています。説明可能なAI(Explainable AI)という意味でXAIという言葉も存在します。たとえば、医療分野では、AIが診断の根拠を説明することが患者や医師の信頼を得るために重要です。また、金融分野では、AIがどのようにリスク評価を行ったかを明確にすることで、意思決定プロセスの透明性を高めることができます。

LLMを利用する人々にとってはプロンプトやRAGのデータ構造などのプロセスを調整すること以外は出たとこ勝負になっているケースが多いです。AIモデルの開発にスポットライトが当たることが多いですが、仮にAIモデルの論理構造が明らかになるのであればより精度向上に寄与することは確かなので、解釈性向上の分野がより注目されればと思っています。