Sakana AIは、新たな知識蒸留手法「TAID(Temporally Adaptive Interpolated Distillation)」を用いた小規模日本語言語モデル「TinySwallow-1.5B」を公開しました。「TinySwallow-1.5B」は日本語の性能において、小型モデルの中で最高のスコアを記録しており、また小型ゆえに、オフラインのモバイル端末での利用も可能であり、今後のAIモデルの普及をさらに後押しするでしょう。

TinySwallow-1.5Bについて

Sakana AIは、新たな知識蒸留手法「TAID(Temporally Adaptive Interpolated Distillation)」を用いた小規模日本語言語モデル「TinySwallow-1.5B」を公開しました。

近年、大規模言語モデル(LLM)は日常会話のみならず、数学やプログラミングといった高度なタスクも人間に匹敵する精度でこなせるようになっています。しかし、こうしたLLMの普及には計算資源の莫大な消費が伴い、開発や運用のコストが大きな課題となっています。特に、スマートフォンやパソコンといったエッジデバイス上での運用を目指す場合、その制約はさらに顕著になります。

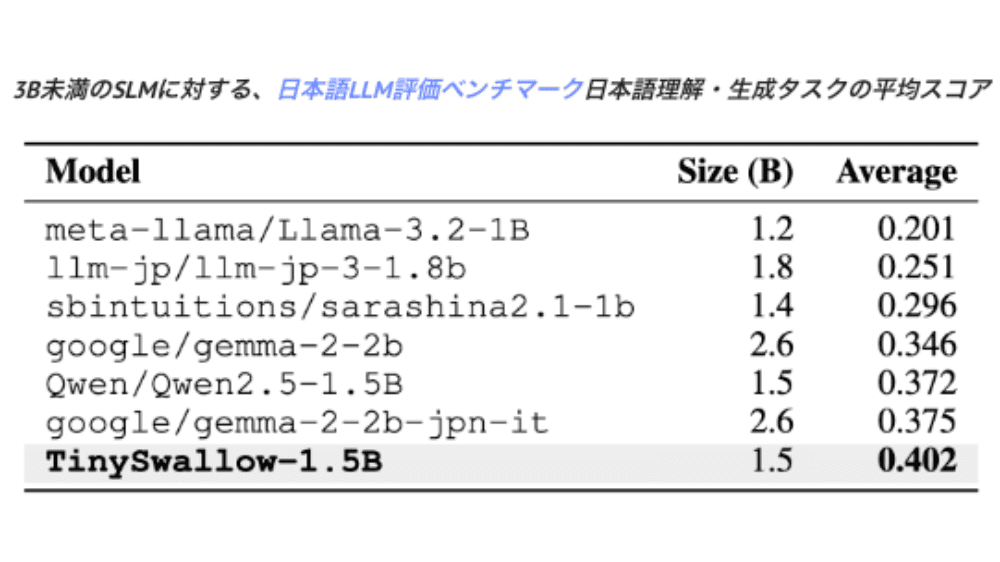

このような課題に対し、Sakana AIは「小規模ながら高性能な言語モデル(SLM)」の開発に注力し、その成果としてTinySwallow-1.5Bを発表しました。このモデルは、わずか1.5B(15億)のパラメータを持ちながら、同規模のモデル群の中で最高水準の日本語ベンチマークスコアを記録しています。

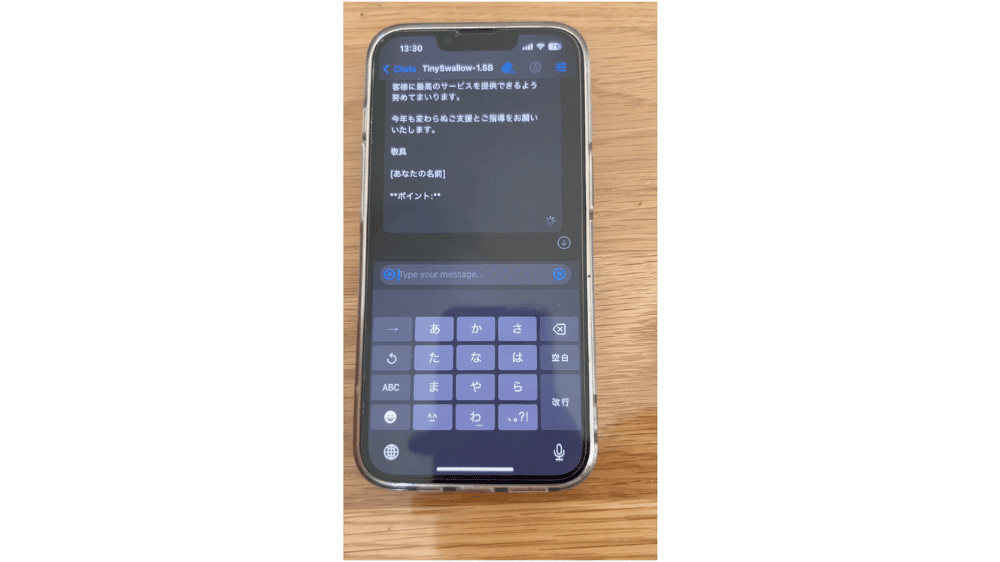

特筆すべきは、その動作環境の柔軟性です。TinySwallow-1.5Bは、ウェブアプリ「TinySwallow ChatUI」を通じてブラウザ上で動作し、最初のモデルのダウンロードが完了すれば完全オフラインでの利用が可能です。従来のLLMと比較して計算資源を大幅に抑えつつ、高い応答性能を実現することに成功しています。

新技術「TAID」とは

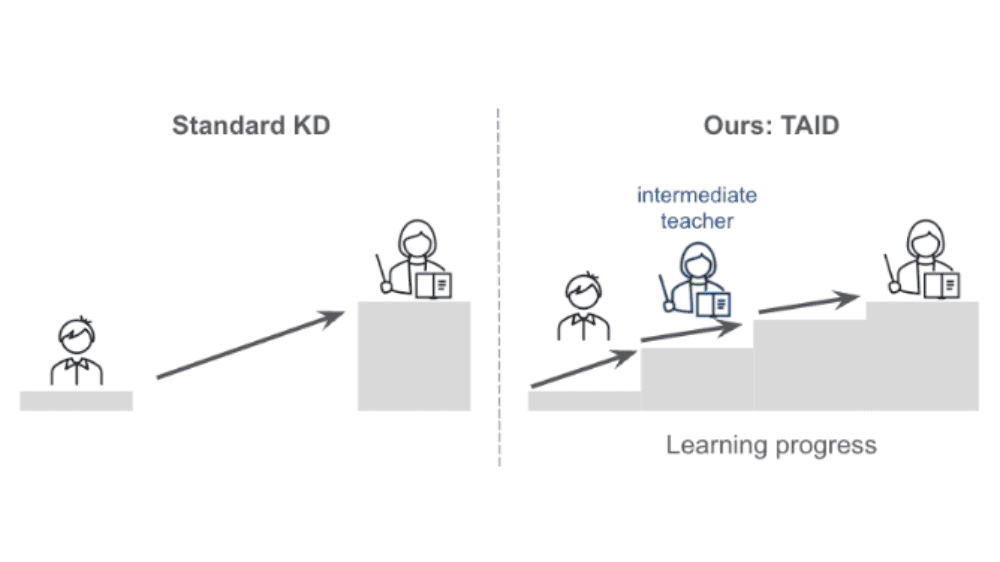

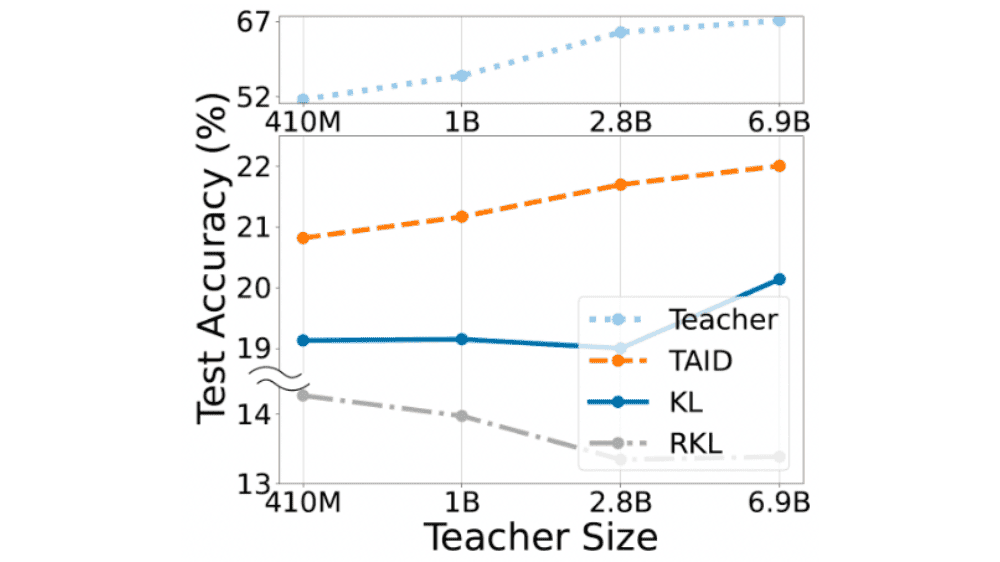

TinySwallow-1.5Bの開発において大きな役割を果たしたのが、新技術「TAID」です。TAIDは、LLMの知識をSLMに効率よく転移するための知識蒸留の新しい手法です。従来の知識蒸留手法では、教師モデルとして用いるLLMの性能が高すぎると、生徒モデルとなるSLMがその知識を適切に学習できないという課題がありました。まるで大学院レベルの講義を小学生に教えようとするようなもので、知識の乖離が大きすぎると学習の効果が十分に得られないのです。この問題を解決するために、TAIDでは生徒モデルの学習段階に応じて教師モデルを段階的に変化させる「中間教師(intermediate teacher)」の概念を導入しました。学習の初期段階では理解しやすい教師を用い、徐々に高度な知識を持つ教師へと移行することで、無理なく高性能なSLMを構築することが可能となりました。

TinySwallow-1.5Bの特徴

このTAIDを活用することで、TinySwallow-1.5Bは大規模なモデルから段階的に知識を学び取り、その知識を小規模ながらも高精度で活用できるようになりました。TAIDを用いた知識蒸留により、320億パラメータのLLMから1.5BパラメータのSLMへと効果的に知識を転移し、結果として1.5Bパラメータモデルとして最高水準の日本語言語処理能力を持つモデルが誕生したのです。

TinySwallow-1.5Bの特徴は、その高い性能だけではありません。オフラインでの利用が可能ですので、個人情報や機密データを外部に送信することなく、安全にAIを活用できます。例えば、社内文書や個人メモを活用したカスタマイズ可能なAIアシスタントとしての利用や、オフラインゲームにおけるAIキャラクターの実装、小型AIエージェントの開発など、様々な応用が考えられます。特に、プライバシーを重視する企業や個人にとって、クラウド環境を介さずに高度なAIを利用できるという点は大きなメリットとなります。

「TinySwallow-1.5B」について一言

かなりテクニカルな内容ですが、やっていることはシンプルで計算資源を必要としない小型モデルの高品質版を開発したという内容です。小型であるということは計算資源を必要としないこと以外に、容量を食わないのでモバイルのような小型端末に持ち出すことができます。これにより、インターネットに接続しないオフライン状態でもAIを使うことができるので、より広いシーンで利用することができ、AIの普及に一役買うのではないか、ということまで言えるかと思います。

とても面白いのは、アプローチとして採用されているTAIDが自然界の法則にインスパイアされた手法であることです。能力差の大きいモデルからよりも、能力差の近しいモデルから学んだ方が学習効率が良い、ということなのですが、これは人間も同じだな、と思います。あまりにも実績も能力もかけ離れた成功者を目標としていても一向に距離が詰まらないので、身近で自分より少しだけ能力の高いモデルケースに追いつくスプリントを回した方が効果的、と置き換えると非常に納得感があります。自然界の論理がAI研究に生きるというのは、自然な気もしますが、驚きでもありますね。

引用元のSakanaAIさんのウェブサイトの記事もテック企業としては信じられないくらいわかりやすいので覗いてみてください。