生成AI技術の急速な発展に伴い、企業や公共機関における業務変革の検討が進む一方で、事実に基づかない情報を生成してしまう「ハルシネーション」の問題が浮上しています。NECはテキスト分析技術および大規模言語モデル開発(LLM)のノウハウを活用し、生成AIの信頼性を向上させる新機能を提供開始しました。NEC開発の生成AI「cotomi」のほか「Microsoft Azure OpenAI Service」への適用も可能です。

ハルシネーション対策の新機能

NECが提供を開始した新機能は、LLMによる文章生成の際に発生する誤りや齟齬を特定する技術をベースにしています。この機能は、生成された文章と参照元の文章を比較し、情報の欠落や意味の変化を提示することが可能です。単語の単純な比較に留まらず、文章全体の意味を捉えた比較が行われるため、要約前後の整合性やハルシネーションの有無を判断し、人的な確認作業の負担を大幅に軽減します。

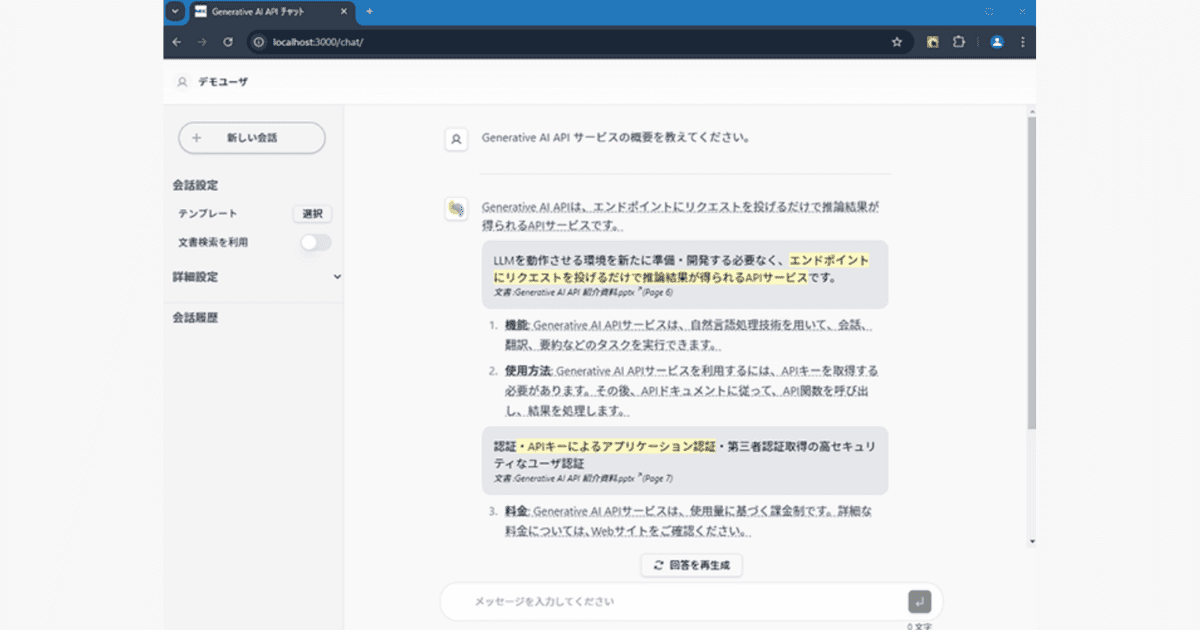

また、情報検索におけるRAG(Retrieval-Augmented Generation:テキスト生成時に外部情報の検索を組み合わせる技術)技術においても有効です。ユーザーがLLMに質問した際、その回答の根拠となる元の文章が提示されるため、生成された情報の正確性を効率的に確認することができます。これにより、LLMを利用した業務における精度向上が期待され、特に情報の正確性が求められる医療や金融分野での利用が見込まれます。

NECは、今回提供する機能をさらに強化する予定です。具体的には、固有名詞の一致度をスコア化する機能や、文章全体の一貫性を検証する機能を追加することで、ハルシネーション対策の信頼性を高めます。また、これらの機能をオンプレミス環境に対応させることで、幅広い企業や業界での導入を促進します。

「NECのハルシネーション対策」に一言

昨日のDataGemma(Googleの開発したハルシネーション対策小型モデル)に続いて、トピックが被ってしまいました。

利用画面程度しか公開されていませんが、とてもきめ細やかでNECらしい印象です。ハルシネーションと思われる箇所を細かく明示してくれるのは助かります。一方で、この手の仕組みはあまり厳密性を重視すると使われない可能性もあるので、いかにシンプルに、評価を可視化するかが大事ではないかと思います(スコアで表示するなど)。

ハルシネーションひとつとっても英語領域ではOpenAIやGoogleといった計算能力とデータセットを持った企業が強いと思うので、特に日本語の領域ではNECの動きに注目です。