生成AIで話題になる「ハルシネーション」とは、誤ったり、意図しない回答が出力されることですが、そもそもなぜハルシネーションが課題となっているかというと、生成AIの開発者自身も生成AIのメカニズムを理解しきれていないためです。

生成AIのメカニズムの研究は様々な機関で行われていますが、今回はOpenAIが1,600万個にも及ぶGPT-4の思考パターンを明らかにしたということで、その手法をなるべく簡便にご紹介したいと思います。

これまでの経緯

人間が作り出した多くものとは異なり、ニューラルネットワーク(*)のメカニズムを理解することは容易ではありません。例えば、エンジニアは車の部品の仕様に基づいて設計、評価、修理ができ、安全性と性能を確保することができます。

*ニューラルネットワーク:人間の脳に似た方法で意思決定を行う機械学習プログラムまたはモデルのこと。

しかし、ニューラルネットワークは直接設計されるわけではなく、それを訓練するアルゴリズムが設計されます。その結果得られるネットワークはよく理解されていません。このため、AIの安全性については、車の安全性と同じように理論的に考えることはできません。

ニューラルネットワークのメカニズムを理解するために、これまでは「ニューロン」という脳の神経回路の最小単位が用いられていましたが、2023年10月には「フィーチャー(特長)」という単位が用いられるようになりました。

ニューラルネットワークを特徴ごとに分類することで、「法律文章に反応する特徴」「DNA列に反応する特徴」といった解釈可能なパターンを見つけ出すことが可能となり、ニューラルネットワークの仕組みの理解につながることが期待されています。

参考:https://gigazine.net/news/20231010-decomposing-language-models-into-understandable-components/

OpenAIの研究の新規性

「特徴」を見つけ出すために「疎オートエンコーダー」という手法が用いられていましたが、大規模な言語モデルは読み解くためには、それに対応する大きなオートエンコーダーが必要でした。

OpenAIでは、大規模言語モデルに適したオートエンコーダーなどを開発し、「特徴」の可視化と、質の評価を実現し、GPT-4では1,600万もの特徴を発見するに至ったと言うことです。

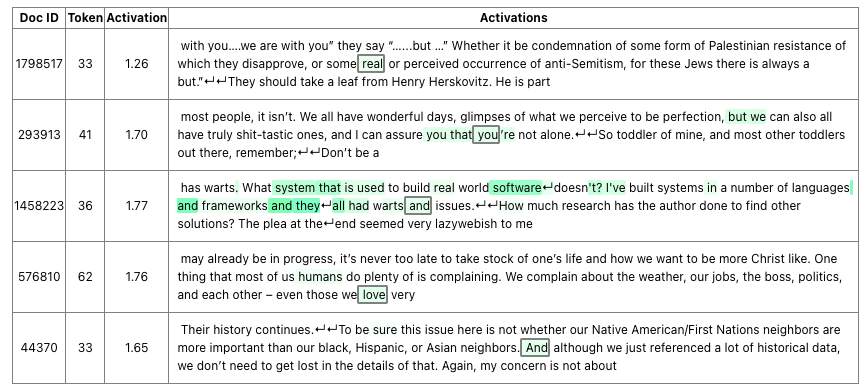

例えば、「Human flawed(人間が欠陥を持つ)」という特徴は次のような学習データと関連している、とされています。非常に難しいですが、人間に置き換えると、こういうこと思うのは(=特徴)、あの記憶(学習データ)があるからだ、という論理構成として理解すると良いと思います。

ニュースについて一言

世の中生成AIブームで、生成AIを使えば全てが解決できるような売り文句も多く見かけますが、現時点ではそんなことはありません。開発者自身がメカニズムを理解していないので、「何とか工夫して90点に近づける」「100点は取れないものだと思って80点で使いこなす」アプローチが取られています。

人間の神経メカニズム自体解明されきっていないので非常にハードルは高いことだとは思いますが、逆にニューロンネットワークが解明された時には良いことも、悪いことも、今以上にできるようになります。

かなり学術的で、うまくお伝えできたかわかりませんが、興味のある方はOpenAIのウェブサイトも併せてみていただけると幸いです。